언제부터 우리가 스크롤을 ‘내려’ 다음 정보를 보는 동물이었던가. 50년 전만 해도 우리는 종이를 넘겨 다음 정보를 읽었다. 그보다 5만 년 전에는 돌이나 나뭇잎 따위를 들추고, 끌어당기고, 만져가며 정보를 얻었다. 그게 당연했다. 2023년 인류는 다시 들추고, 끌어당기고, 만져서 정보를 얻는 시대를 맞이하려 한다. 2차원 화면이 아닌 3차원 공간에서 컴퓨터와 상호작용하는 공간 컴퓨팅의 시대다. 과학자들은 컴퓨터가 만들어낸 가짜 세상 속에서 5만년 전 인류가 그랬듯 ‘본능적으로’ 정보를 주고받을 방법을 지금 연구하고 있다. 그 현장에 다녀왔다.

7월 6일 정오, 대전으로 내려가는 고속열차에 몸을 실었다. 정일권 한국전자통신연구원(ETRI) 초실감메타버스연구소 콘텐츠연구본부장을 만나러 가는 길이었다. 정 본부장은 현재 ETRI에서 오감을 활용해 가짜 세상 ‘메타버스’를 보다 실감나게 만들 방법을 연구하고 있다. 열차 내부에 설치된 화면에선 16년 전 순직한 조종사 고(故) 박인철 소령이 인공지능(AI) 딥페이크 기술의 힘을 빌어 다시 어머니와 얼굴을 마주하는 장면이 재생되고 있었다. 국방부가 지난 7월 5일 공개한 영상이다.

“예전에 TV에서 비슷한 내용을 봤어요. 부부였는데, 한 분이 아파서 돌아가시고 (가상현실로) 재현을 해서, 실제같이. ‘나도 인철이를 저렇게라도 볼 수 있다면’이라는 생각을 했어요.”

박 소령의 어머니가 본 영상은 2021년 방영된 MBC 다큐멘터리 ‘너를 만났다 시즌2’였을 것이다. 남편 김정수 씨가 가상현실(VRVirtual Reality) 헤드셋과 햅틱 글러브를 끼고 병으로 세상을 떠난 아내 성지혜 씨를 만나는 내용이다.

AI 딥페이크 기술은 박 소령의 얼굴과 목소리를 재현했다. VR 헤드셋은 성 씨의 모습을 3차원(3D)으로 보여줬다. 햅틱 글러브는 김 씨가 성 씨의 뺨을 쓰다듬으며 촉감을 느낄 수 있게 해줬다. 그렇게 기술은 먼저 떠나간 이를 꿈에서라도 다시 보고 싶은 이들의 마음을 위로했다.

기술을 개발했던 과학자들이 이런 쓰임을 처음부터 염두에 둔 건 아니었을 테다. 과학이 하는 일은 언제나 그랬듯, 그저 가능성을 만들 뿐이다. 이 가능성을 갖고 어떤 미래를 만들지는 정하기 나름이다. AI, VR 등 기술의 발전 덕에 ‘가짜 세상’은 점점 더 현실과 닮아간다. 어떤 이들은 가짜 세상을 통해 사람의 마음을 위로하는 미래를 만들었다. 또 무슨 일을 할 수 있을까.

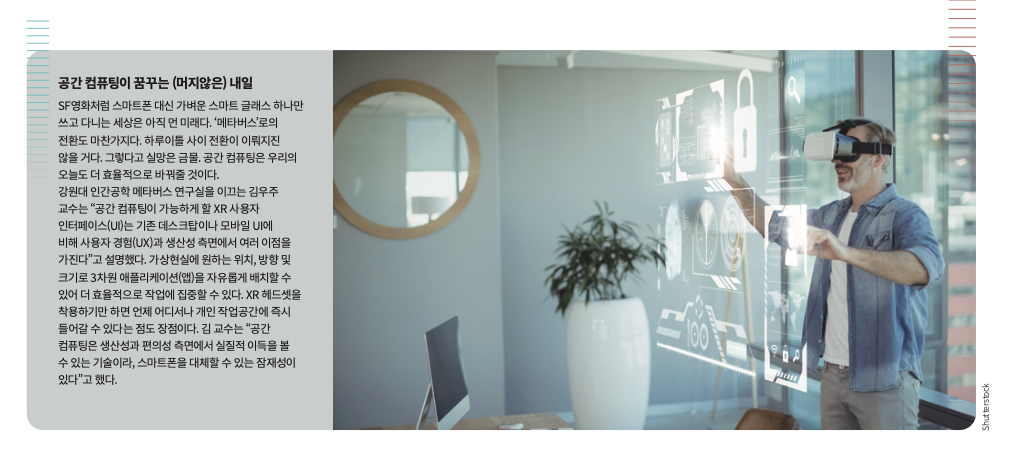

PC, 모바일, 그 다음은 ‘공간 컴퓨터’ 시대

ETRI를 찾은 건 애플이 6월 5일 발표한 ‘새로운 시대’에 대한 궁금증을 풀기 위해서였다. 6월 5일 애플이 개최한 세계 개발자 회의(WWDC)에서 연설을 하던 팀 쿡 애플 최고경영자(CEO)가 “한 가지 더 있다(One more thing)”며 좌중의 시선을 휘어잡았다. ‘원 모어 띵’은 스티브 잡스가 신제품을 발표할 때 사용하던 말이다. 이날 애플은 애플워치 이후 9년 만에 신제품 ‘비전 프로’를 내놓았다. 비전 프로는 머리에 착용해 확장현실(XRExtended Reality)을 경험할 수 있는 고글 형태의 헤드셋이다. 이런 제품을 ‘XR 헤드셋’이라고 부른다.

XR 헤드셋이라는 제품 자체는 메타가 꾸준히 시장에 내보내고 있었다. 새로운 기계가 아니다. 그런데 애플은 비전 프로를 XR 헤드셋이라고 부르지 않았다. 대신 ‘공간 컴퓨터’라는 말을 썼다. 쿡 CEO는 “맥을 발표하며 개인 컴퓨터의 시대를, 아이폰을 통해 모바일 컴퓨터의 시대를 열었듯, 비전 프로를 통해 공간 컴퓨터의 시대를 열겠다”는 포부를 밝혔다. 비전 프로를 통해 시대의 세 번째 전환을 주도하겠다는 뜻이다.

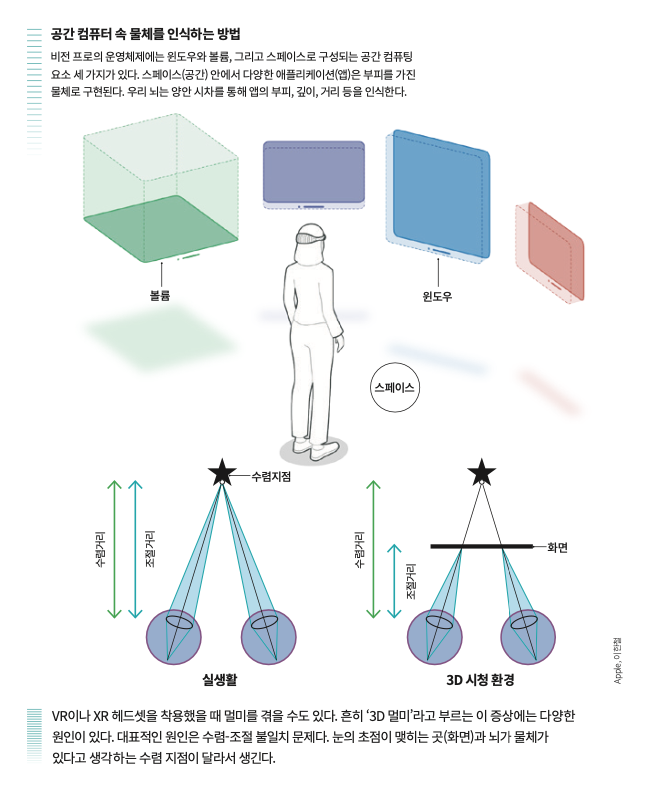

공간 컴퓨터를 가능케 하는 기술 ‘공간 컴퓨팅’은 2003년 미국의 컴퓨터공학자 사이먼 그린월드가 처음 사용한 말이다. 쉽게 말해 인간과 컴퓨터가 공간을 통해 상호작용하는 기술이다. 우리가 사용하는 컴퓨터를 떠올려보자. 데스크탑 컴퓨터, 노트북, 스마트폰 모두 2D 화면으로 정보를 얻는다. 화면 속 정보를 키보드, 마우스, 또는 터치패널 등으로 조작한다.

공간 컴퓨터를 통해서는 3D로 구현된 물체를 손으로 움직여가며 정보를 얻을 수 있다. 헤드셋을 쓰면 컴퓨터가 만든 공간이 나타난다. 애플리케이션(앱)이 그 위에 떠오른다. 손가락의 움직임이나 시선, 그리고 음성으로 앱을 구동하는 방식이다. (헤드셋을 쓰지 않은 사람의 시선으로 보면 허공에 손을 휘적거리는 모습만 보인다.)

애플은 “비전 프로는 가장 자연스럽고 직관적인 입력체계인 눈, 손, 음성으로 제어되는 3D 사용자 인터페이스를 선보인다”면서 “디지털 콘텐츠가 실제 공간에 물리적으로 존재하는 것 같은 느낌을 제공한다”고 했다. 우리는 시각, 청각, 촉각, 미각, 후각까지 오감으로 현실을 인식한다. 그래서 ‘실제 공간에 물리적으로 존재하는 것과 같은 디지털 콘텐츠’에는 궁극적으로 오감이 모두 구현돼야 한다. 애플이 비전 프로를 통해 구현한 감각은 시각과 청각뿐이다. 공간 컴퓨터가 이름값을 하기 위해서는 갈 길이 많이 남은 셈이다. 정 본부장에게 그 길을 물었다.

VR・AR・MR을 모두 포함하는 XR

정 본부장은 시각마저도 “아직 부족하다”고 평했다. “우리가 현실세계를 접하는 대로 구현해야 합니다. 영화 ‘레디 플레이어 원’에서는 장치를 착용하면 완전히 현실과 구분할 수 없는 세상이 펼쳐지죠. 그 정도 수준까지 가야 합니다.” 2018년 개봉한 스티븐 스필버그 감독의 SF영화 레디 플레이어 원의 배경은 VR 기술이 고도화된 2045년이다. 영화 속 등장인물들이 VR 게임 ‘오아시스’에 접속해 펼쳐지는 이야기를 다룬다.

시각을 구현하는 기기는 크게 두 방식으로 나뉜다. MS의 홀로렌즈처럼 주변 환경이 그대로 렌즈에 투과돼 보이는 방식이나, 애플의 비전 프로나 메타의 퀘스트처럼 시야가 화면으로 막혀 있는 방식이다. 각각은 개념적 배경부터 다르다.

홀로렌즈는 대표적인 ‘AR 글래스’로 꼽힌다. AR은 현실에 정보를 덧씌우는 개념인 증강현실(Augmented Reality)의 약자다. AR 글래스를 착용하면 안경처럼 렌즈에 주변 환경이 투과돼 보이는 한편, 그 위에 다양한 이미지와 글자가 덧씌워져 추가 정보를 알 수 있다. 한편 메타의 퀘스트는 원래 VR 헤드셋 오큘러스부터 시작된 제품이다. VR은 현실에 없는 가짜 세상을 구현하는 개념이다. VR 헤드셋을 착용하면 헤드셋 내부 화면에 3D 공간이 나타난다.

여기서 한발 더 나아간 기기가 XR 헤드셋이다. 비전 프로의 경우, 외부 카메라로 주변 환경을 촬영해 공간을 인식한다. 그리고 이렇게 인식한 공간을 다시 내부 화면에 3D로 구현한다. 앱은 그 위에 부피감을 가진 실제 물체처럼 나타난다. 가짜 공간을 만드는 VR과 현실에 추가적인 정보를 덧씌우는 AR이 ‘혼합’됐다. 이 개념을 혼합현실(MRMixed Reality)이라고 부른다. 그리고 AR, VR, MR을 모두 포괄하는 개념이 바로 확장현실(XRExtended Reality)이다.

정 본부장은 “비전 프로의 경우 AR을 완전히 구현하지는 못했다”고 했다. 비전 프로가 AR을 제대로 구현하려면 비전 프로를 착용하고 본 현실과 실제 현실이 같아야 한다. 하지만 현재 XR 헤드셋을 통해 구현되는 AR은 수렴-조절 불일치라는 문제를 안고있다. 쉽게 말해 ‘멀미’다.

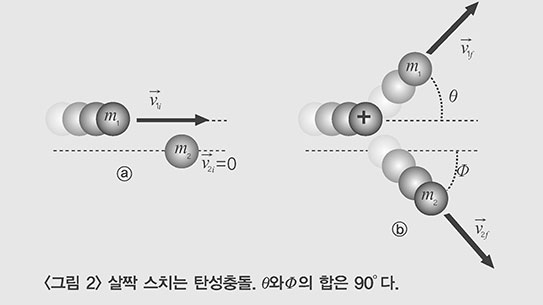

수렴-조절 불일치 문제는 VR이나 XR 헤드셋이 공간의 깊이를 나타내는 방식 때문에 발생한다. 우리 뇌는 물체의 깊이 정보를 양 눈의 시차를 이용해 인식한다. 시차란 하나의 물체를 서로 다른 두 지점에서 봤을 때 나타나는 방향 차이다. 왼쪽 눈과 물체, 그리고 오른쪽 눈이 이루는 각도는 멀리 있는 물체를 볼 때보다 가까운 물체를 볼 때 더 벌어져 있다. 뇌는 이런 각도차를 토대로 물체까지의 거리를 알아낸다.

VR과 XR 헤드셋도 양안 시차를 적용한 영상을 양 눈에 각각 보여줌으로서 공간의 깊이감을 전달한다. 이러면 뇌는 헤드셋이 보여준 영상에 따라 물체의 위치를 인식한다. 그런데 눈은 다르다. 눈은 헤드셋 속 화면 자체를 물체로 인식하고, 거기에 맞춰 초점을 조절해야 한다. 눈이 초점을 맞춘 물체의 위치와 뇌가 인식하는 물체의 위치가 달라진 것이다. 이 불일치 때문에 멀미가 생긴다. 그 외에 우리는 이미 고개를 돌렸는데 컴퓨팅 속도 때문에 화면은 조금씩 늦게 나타나는 지연 문제도 멀미의 원인이 된다. 두 문제 모두 헤드셋이 시각을 현실 그대로 구현하지 못하기 때문에 온다. 정 본부장은 “이런 문제들을 해결해야 온전한 AR이라고 부를 수 있다”고 했다.

오감 느끼는 ‘진짜 XR’ 구현하려면

XR은 비단 시각에만 국한된 개념이 아니다. 정 본부장은 “후각, 청각, 촉각 등 감각을 구현하는 모든 장치를 XR 장치라고 부를 수 있다”고 했다.

오감을 인식하고 재현하기 위한 연구는 현재진행형이다. 청각은 쉬운 듯 어렵다. 청각을 인식하고 전달하는 기술은 시각만큼이나 친숙하다. 기자는 이 문장을 쓰는 지금도 청각을 인식하고 전달하는 기기인 이어폰을 꽂고 있다. 하지만 세상에 없는 소리를 만드는 건 어렵다. 정 본부장은 “가상현실을 제대로 구현하려면 가상의 소리를 만들 수 있어야 한다”고 했다. VR로 구현된 가짜 정원에서 가짜 사과를 떨어뜨린다고 생각해보자. 어떤 소리가 나야할까. 정 본부장은 “(다양한 상황에서 물리시스템을 시뮬레이션해 시각적으로 구현하는) 물리엔진의 소리 버전이 필요할 것” 이라고 내다봤다.

촉각의 경우엔 물체를 ‘만진다는’ 감각을 주는 기술이 개발 중이다. ETRI에서는 초음파 에어햅틱 연구가 한창이다. 초음파 스피커를 수십~수백 개 배열한 뒤 스피커를 조절하면 음파가 특정 위치에서 중첩되게 만들 수 있다. 이런 원리로 손에 압력을 가해 실제로 물체를 만질 때처럼 손에 ‘밀리는’ 느낌을 주는 것이다. ETRI에서 2018년 개발한 ‘에어 피아노’가 대표적인 사례다. 에어 피아노를 이용해 공중에서 피아노 건반을 치는 느낌을 받을 수 있다.

미각과 후각은 각각 맛과 냄새를 전달하는 화학물질을 조합하는 방식으로 재현한다. 정 본부장은 “그 밖에도 맛을 보지 않고도 맛을 느낄 수 있도록 신경계에 직접 신호를 주는 BCI 기술도 좋은 방식이 될 것”이라며 “아주 먼 미래에는 미각뿐만 아니라 오감을 BCI기술로 재현하는 방향으로 연구가 이어질 것으로 예상한다”고 했다. 뇌-컴퓨터 인터페이스(BCIBrain Computer Interface) 기술은 뇌와 컴퓨터를 연결해 상호작용하도록 하는 장치를 말한다. 영화 ‘매트릭스’에는 신경계에 전극을 꽂아 가상현실 속으로 들어가는 장면이 나온다. 이때 사용한 기술도 BCI의 일종이라 볼 수 있다. SF 영화 속에서나 보던 미래가 성큼 다가온 것이다.

공간 컴퓨팅이 꿈꾸는 가짜 세상의 미래

비전 프로가 공개된 이후로 공간 컴퓨팅이란 키워드가 화제다. 2년 전 유행하던 메타버스를 슬며시 떠올린 사람이 기자만은 아닐 듯하다. 메타버스는 컴퓨터가 만든 가짜 세상을 뜻한다. 공간 컴퓨팅은 현실과 상호작용하는 방법 그대로 컴퓨터와 상호작용하도록 만드는 기술이다. 결국 공간 컴퓨팅은 메타버스를 이루는 기술적 뼈대가 될 수 있는 셈이다. 공간 컴퓨터의 시대는 메타버스로의 전환을 이끌어낼 수 있을까.

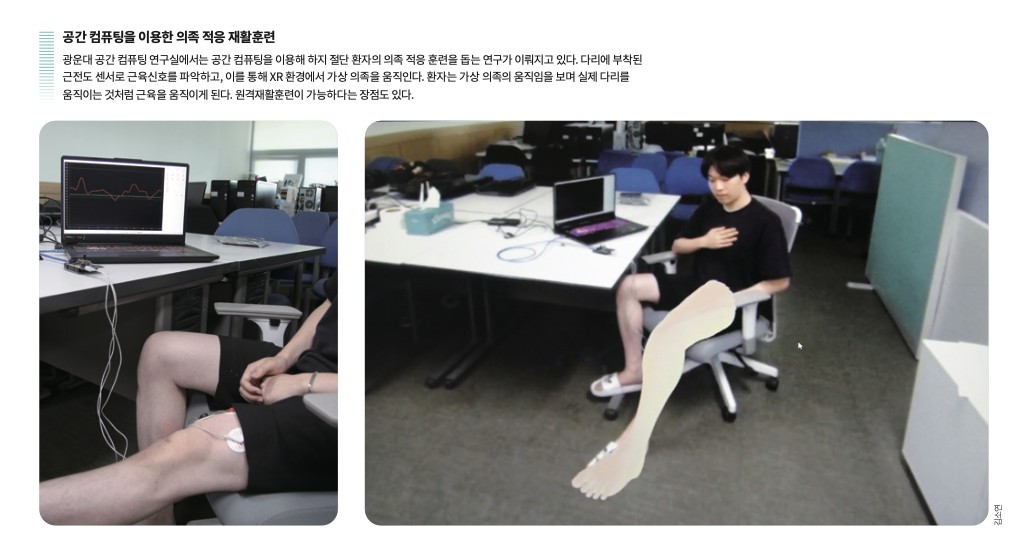

7월 7일 광운대 공간 컴퓨팅 연구실에서 만난 권순철 광운대 스마트융합대학원 정보융합시스템학과 교수는 “메타버스는 기술적 개념보다는 철학적 개념”이라면서 “최근 들어 메타버스를 만드는 기술의 개발 주기가 빨라진 것은 사실”이라고 답했다.

기술 개발 속도의 가속화에는 AI가 큰 역할을 했다. 권 교수는 비전 프로에도 적용된 시선추적 기술과 동작추적 기술을 그 예로 들었다. 시선추적 기술은 사용자의 눈을 분석해 어디를 바라보는지 알아내는 기술이다. 이전에는 기기 사용에 앞서 다양한 거리, 위치에 있는 물체를 바라볼 때 눈동자의 움직임을 미리 파악하는 ‘캘리브레이션’ 과정이 필수였다. 이 때 얻은 정보는 눈동자 움직임을 분석할 기초자료가 된다.

AI는 기계학습을 통해 캘리브레이션 과정 없이 눈동자의 움직임을 바로 분석할 수 있다. 사용자의 움직임을 분석하는 동작추적 기술도 마찬가지다. 이전에는 접촉식 센서를 관절마다 붙여 움직임을 측정하고 분석했지만, 이제는 카메라로 움직임을 촬영한 뒤 이걸 AI로 분석하면 되니 훨씬 빠르고 범용성이 강해졌다.

물론 넘어야 할 장벽은 여전히 많다. 권 교수는 앞으로의 장벽을 크게 장치, 콘텐츠, 플랫폼, 네트워크 네 종류로 나누어 설명했다. 우선 장치다. 현재의 투박하고 커다란 ‘헤드셋’ 형태는 한계가 있다는 게 그의 생각이다. 안경 정도로 장치가 간단해지거나, 혹은 안경 없이 허공에 이미지를 띄우는 홀로그램 기술이 대안이 될 수 있다. 2D를 염두에 두고 나온 현재의 콘텐츠가 3D로 전환돼야 한다는 부분도 장벽이다. 3D 공간을 있는 그대로 기록하거나, AI로 가상 공간을 쉽고 빠르게 만드는 기술이 필요하다. 누구나 어떤 장비를 사용하든 상관없이 콘텐츠를 접할 수 있는 공간 컴퓨터용 플랫폼도 필수다.

XR 헤드셋의 경우 복잡한 공간 컴퓨팅을 할 수 있으면서도 머리에 쓸 수 있을 정도로 작은 장비를 만드는 부분이 특히 어렵다. 두 기능을 나누면 어떨까. 권 교수는 “컴퓨팅은 클라우드에서 하고, 기기는 사용자의 눈에 공간을 보여주는 역할만 수행하는 개념으로 가야 한다”면서 5G, 6G 등 모바일 네트워크를 통한 스트리밍 방식을 제안했다.

“스마트폰이 안경으로 대체되는 거죠. 지금의 두꺼운 XR 헤드셋보다 더 가벼운 스마트 글래스가 나오면 사람들이 많이 사용할 겁니다. 저는 먼 미래에는 모두 스마트 글래스를 착용하고, 이 스마트 글래스가 실시간으로 제공하는 정보를 보는 세상이 올 거라고 생각합니다. 스마트폰이 나오기 전 우리는 머릿속에 모든 지식을 집어넣고 있는 ‘걸어다니는 백과사전’을 인재라고 생각했죠. 스마트폰 이후에는 주어진 정보를 가지고 참신한 결과물을 만드는 응용력이 중요한 역량이 됐습니다. 공간 컴퓨팅의 세계가 온다면 또 모르죠. 그때는 실시간으로 보이는 정보를 잘 잡아내는 순발력도 하나의 역량으로 평가받을 수도 있겠습니다. 가봐야 알겠죠.”