.jpg)

이런, 가짜 뉴스는 세계적으로 큰 문제구나! 과연 어떻게 해야 속지 않을 수 있을까…, 응? 눈을 바라보면 비밀을 알 수 있을 거라고?

가짜 영상의 비밀은 눈 속에 숨겨져 있다?

다행스럽게도 아직은 그럴듯한 딥페이크 영상을 만들기가 쉽지 않아요. 특정 인물의 영상을 만들려면 그 사람의 모습이 담긴 데이터가 많이 필요한 데다 영상을 만드는 데도 오랜 시간이 걸리거든요. 그래서 대부분의 딥페이크 영상은 조금만 주의를 기울이면 분간해낼 수 있어요.

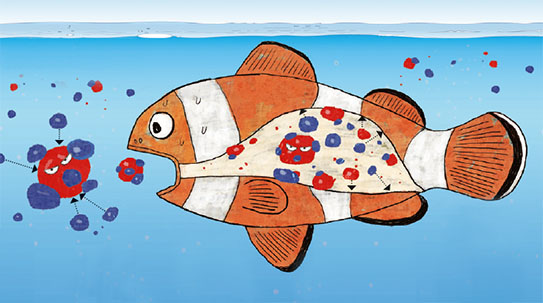

예를 들어, 미국 뉴욕주 올버니대학교 컴퓨터과학부의 류시웨이 교수는 그 방법 중 한 가지로 ‘눈 깜빡임’을 제시했어요. 사람은 보통 대화하면서 2~10초에 한 번씩 눈을 깜빡여요. 그런데 딥페이크로 만들어진 가짜 영상에 등장하는 인물은 눈을 거의 깜빡이지 않아요. 즉, 등장인물이 눈을 깜빡이지 않는다면 조작된 영상으로 추측할 수 있지요.

.jpg)

.jpg)

이렇게 딥러닝이 만든 영상이나 이미지에서 나타나는 특별한 실수를 ‘아티팩트’라고 불러요. 얼굴을 만드는 적대적 생성망이 배경이나 머리카락을 이상하게 그리는 것도 아티팩트에 속하죠. 연세대학교 컴퓨터과학과의 남건희 연구원은 “적대적 생성망의 종류에 따라 다른 아티팩트를 만든다”며, “이 아티팩트를 수집하여 인공지능을 학습시키면 조작된 영상을 찾을 수 있다”고 밝혔어요. 아쉽지만 가짜 뉴스는 막기가 힘들어요. 가짜 뉴스를 완전히 막아주는 기술이 개발되지 않았거든요. 가짜 뉴스를 만들거나 퍼뜨리는 사람들을 법으로 규제할 수도 있지만, 법이 만들어지고 자리를 잡으려면 많은 시간이 필요하죠.

그래서 유튜브나 TV 등에서 나오는 뉴스가 진짜인지 가짜인지 스스로 판단할 수 있는 능력이 필요해요. 이를 ‘미디어 리터러시’라 해요. 중요한 뉴스라고 생각하면 그 내용의 출처를 알아보고, 신뢰성 있는 언론에서 같은 내용을 다시 확인해보는 거죠. 간단하지만 이런 과정을 통해 가짜 뉴스를 걸러낼 수 있답니다!

.jpg)