구글과 휴대전화. 가장 먼저 떠오르는 것은 단연 스마트폰 운영체제인 안드로이드다. 세계에서 가장 많은 사람들이 안드로이드 기반 스마트폰을 쓴다.

그런데 구글은 이제 휴대전화 자체에 공을 들인다. 사람의 눈과 귀 역할을 하는 휴대전화, 손으로 쓱~ 글자를 쓰기만 하면 바로 해당 내용이 검색되는 휴대전화를 꿈꾼다. 스마트폰 화면에 나오는 키보드가 필요 없을 정도로 사람이 지닌 감각을 휴대전화가 모두 해결하겠다는 생각이다.

사람의 ‘오감’에 휴대전화의 ‘감각 기관’이 합쳐져 ‘육감(Sixth sense)’이 되는 세상이 왔다.

지난 2월 말, 구글 본사가 있는 미국 마운틴뷰. 아침저녁으로는 쌀쌀하지만 낮에 내리쬐는 태양이 제법 따뜻한 낮에 스콧 허프만 구글 엔지니어링 부사장을 만났다. 그의 역할은 휴대전화의 음성 검색 서비스 총괄이다.

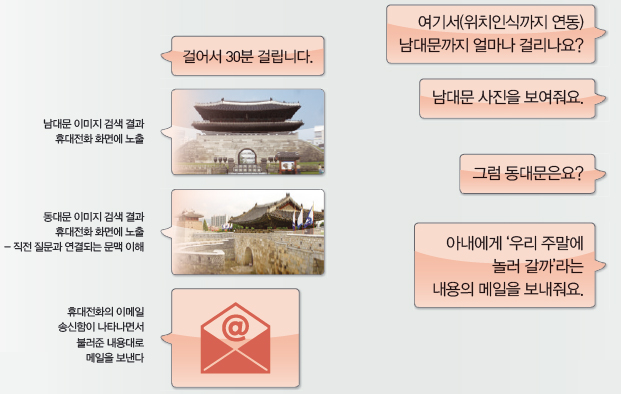

“사람들이 컴퓨터로 검색할 때는 키워드 중심이지만 휴대전화에 말을 할 때는 ‘서울 날씨’ 등과 같은 간단한 단어가 아니라 ‘이번 주 토요일 서울 날씨는?’과 같은 자연스러운 문장을 더 선호합니다. 어떻게 사람들의 말을 휴대전화가 알아듣게 할 수 있을까가 바로 구글 음성 검색의 화두입니다.”

허프만 부사장은 음성 검색이 원활해지기 위해서는 ‘음성을 정확히 인식하는 것’ ‘자연어, 즉 문장을 이해하는 것’ ‘정보를 제공하는 지식그래프’ 등 3가지 조건이 필요하다고 설명했다.

“한번 보여드릴까요?” 허프만 부사장의 자신만만한 표정이 읽혔다. 여러 문장을 제대로 인식하는지 보여달라고 했다

“샌디에이고 이번 주말 날씨가 어떤가요?(물론 영어로. What is the weather like in San Diego this weekend?)”라고 휴대전화에 물어보자 대답이 음성으로 나온다. 어떻게 이처럼 정확히 대답할 수 있는지 묻자 허프만 부사장은 “사람들이 많이 묻는 질문일수록 패턴을 만들어 기계적인 처리를 통해 대답할 수 있도록 알고리듬을 만든 것”이라고 웃으며 소개했다. 다음 질문은 더 어려웠다.

“그렇다면 샌프란시스코는? (How about San Francisco?)”이라고 묻자 “아침 기온이 9℃이며 오후 늦게 비가 올 수도 있습니다”라는 대답이 돌아왔다. 어리둥절한 표정을 짓자 “방금 본 것처럼 휴대전화 음성검색이 문맥과 대화 상황을 이해하기 시작했습니다”고 허프만 부사장이 말했다.

‘한국의 대통령 이름은?’이라는 질문에는 ‘한국 대통령 이름은 팍~근하이~(‘혜’ 발음이 어려웠으리라)’라는 대답이 나왔다.

곧이어 ‘그 사람 나이가 몇 살인가?(How old is she?)’라고 묻자 ‘그녀의 나이는 61세(미국 나이)’라고 곧잘 말한다.

정말 휴대전화는 사람과 대화를 나눌 수 있게 된 걸까.

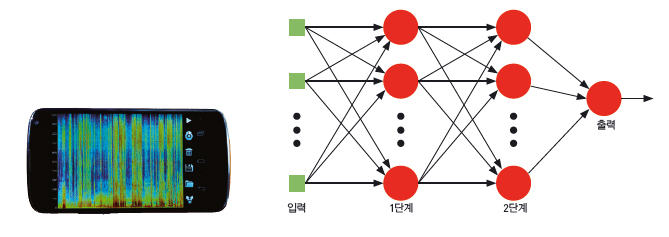

단어 하나를 말하면 검색 결과가 나오는 음성 검색은 이미 대중화됐다. 하지만 이제 관심은 자연스런 문장 검색이다. 문맥까지 파악해 간단한 수준의 문답까지 할 수 있는 구글 음성 검색은 어떤 원리로 가능해진 걸까. 스콧 허프만 부사장은 “오디오 신호 데이터를 분석하는 기술과 신경망 이론에 의해 가능해집니다”라고 설명했다. 물론 자연어 문답 수준의 구글 음성 검색은 현재 영어로만 가능하다.

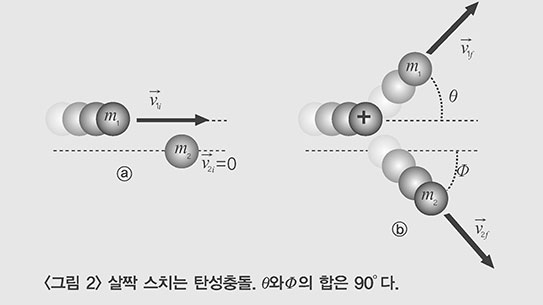

오디오 신호 데이터를 분석하는 데는 ‘스펙트로그램’ 방식이 쓰인다. 소리를 시각 데이터로 만드는 방법이다. 단어를 이루는 자음과 모음을 분류해 놓고 각 자음과 모음이 소리로 들릴 때의 진동 폭을 데이터로 만든다. 여기서부터는 사람의 뇌를 흉내 내는 인공지능 신경망 이론을 적용한다. 사람의 뇌는 자극과 흥분 등 신호를 전달하는 약 1000억 개의 뉴런(신경세포)으로 이뤄진다. 뉴런은 다른 뉴런과 수많은 시냅스(연결부위)를 이루고 있다.

이런 복잡한 신경 네트워크, 즉 뇌가 가장 놀라운 점 중 하나는 연상과 추측이다. 사람의 뇌는 그림의 일부만 보고도 그림의 전체를 연상할 수 있다. 모나리자의 눈만 봐도 모나리자 전체를 떠올리는 것과 같다. 신경망 이론은 컴퓨터가 사람의 뇌처럼 제한적인 정보와 데이터만 있어도 정확한 추측과 정보를 얻을 수 있도록 해준다.

특정 자음이나 모음을 말할 때 나올 수 있는, 가능한 모든 진동 폭의 데이터를 여러 층으로 나눠놓으면 실제로 입력한 데이터가 여러 층(결국 데이터베이스다)을 지나가면서 보다 정확한 음성으로 인식하는 것이다.

복잡한 신경세포 네트워크가 특정한 방식으로 신호를 주고받듯 구글은 여러 층으로 나누어진 데이터를 통해 언어(여기서는 말)가 어떻게 이뤄지는지 다양한 모델을 개발했다.

허프만 부사장은 “구글 음성검색은 말소리에서 나오는 스펙트로그램을 순식간에 분석하고 이를 바탕으로 가능한 단어를 추출해낸다”며 “여기에 모델을 만들고 각 음성 스펙트로그램의 조합으로 이뤄질 수 있는 단어를 데이터로 만든다”고 설명했다. 질문을 이해하고 음성으로 답을 하는 방식은 의외로 간단하다. 이렇게 인식한 단어 중 가장 의미가 있는 단어(문장의 뜻을 지배하는 단어)를 수많은 연산을 통해 골라낸 후 그 단어와 관련돼 사람들이 어떤 질문을 가장 많이 하는지 바로 걸러낸다. 이렇게 되면 질문에 맞는 답을 할 수 있는 동시에 사람들이 실제로 대화하는 패턴까지 학습할 수도 있다. “사투리나 억양(액센트)은 어떻게 처리해요?”

문득 궁금해져 물었다. “마찬가지입니다. 매우 다양한 발음에 대한 데이터를 모으고 신경망 기술로 해결합니다. 다른 억양을 가진 사람이 음성 검색을 이용하면 할수록 더욱 정확해지겠지요.” 허프만 부사장의 설명이다.

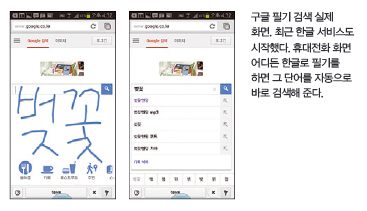

구글 전용 앱을 실행하면 스마트폰 화면 어디에나 손으로 글씨를 쓰면 글자를 인식해 검색창에 해당 글자가 자동으로 뜨며 바로 검색 결과를 보여준다. 스마트폰 화면에 애플리케이션을 띄운 후 자유롭게 손으로 써 해당 키워드를 검색할 수 있다. 로렌스 챙 필기 인식 부문 제품 매니저는 “스마트폰이나 태블릿PC에서 제공하는 키보드를 탭하며 검색하는 것은 상당히 불편하다”며 “키보드 없이 쓰기만 해도 검색이 된다면 모바일 기기의 작은 화면 전체를 이용할 수 있다”고 설명했다.

필적 감정을 구글에 의뢰해도 될까

기본적으로 필기 인식은 좌표를 이용한다. 사용자가 터치 화면에 글을 쓰면 x축과 y축에 대응하는 좌표로 변환한 후 그 정보를 구글 데이터 센터로 전송한다. 전송된 정보와 다른 사람들의 필기 정보를 비교해 근접한 단어를 다시 사용자 검색창에 띄워준다. 이 때 헷갈릴 수 있는 문자나 단어, 숫자는 화면 아래에 해당 문자 모양에 대한 여러 선택 사항을 자동으로 제공해 필기 인식 정확도를 보완하고 있다.

그런데 목소리만큼이나 글씨체는 다양하다. 숫자 ‘1’과 알파벳 소문자 ‘l’, 숫자 ‘0’과 알파벳 대문자 ‘O’를 어떻게 구분할 수 있을까. 다른 사람이 알아보기 힘들 정도로 ‘악필’인 사람이 스마트폰 화면에 쓴 글자를 어떻게 인식할 수 있을까.

챙 매니저는 “클라우드 컴퓨팅에 답이 있습니다”고 말했다. 클라우드 컴퓨팅이란 인터넷에 연결된 데이터 서버에 언제 어디서나 접근할 수 있는 기술이다. 챙 매니저는 “여러 사람이 쓴 필기 샘플을 클라우드컴퓨팅 기술을 이용해 수집하고 분석한다”며 “이미 축적해 놓은 필기 정보를 재빨리 분석해 가장 근접하는 결과를 유추하고 계산해 내는 것이 핵심”이라고 말했다. 그래서 많은 사람들이 필기 검색을 이용할수록 필기 인식의 정확도가 높아진다. 앞으로 문서 위조와 서명 등의 진위 여부를 가려내는 필적 감정 조사를 구글에 맡겨야 할지도 모르겠다. 내가 쓴 글씨 모양과 습관 등 정보를 구글 데이터센터 서버는 이미 알고 있을지도 모르기 때문이다.

경회루 이미지, 모서리 사진 한 장이면 찾는다

뭔가 그럴듯해 보이는 아름다운 건축물을 해외여행 중에 보게 됐다면 어떤 건축물인지 궁금하다. 그런데 건축물 이름을 모르면 인터넷으로 찾기가 어려워진다.

구글 이미지 검색 ‘구글 고글스’는 사진이나 그림 속의 정보를 이용해 유사한 이미지나 이미지의 제목, 인물이나 모형의 정보를 바로 얻을 수 있다. 사진을 찍고 어떤 물체인지 찾아서 알려주는 똑똑한 ‘눈’이 되는 것이다.

사용자가 스마트폰으로 촬영한 이미지를 구글 데이터 센터로 전송하면 구글 시각 알고리듬 소프트웨어를 통해 이미지가 기호로 바뀐다.

이후 데이터 센터에 들어 있는 모든 이미지들과 픽셀(이미지를 구성하는 화소 단위), 색상, 재질 등을 비교한다. 이렇게 나온 정보는 얼마나 유아기기존 이미지와 비슷한지 계산한 뒤 검색 결과를 수 초 내에 보여준다. 만일 외국인이 경복궁에 있는 경회루에 방문해 기둥 하나만 사진으로 찍어 검색한다면 놀랍게도 ‘경회루’ 이미지가 검색결과로 제공될 수 있다.

휴대전화 하나만 들고 다니면 말을 들어주고 촉각도 느끼고 휴대전화가 본 장면에 대한 정보도 제공하는 세상이 구글 데이터 과학에 의해 펼쳐지고 있다.

▼관련기사를 계속 보시려면?

PART 1. 검색은 김수현(작가, 탤런트)을 구분할 수 있을까

PART 2. Sixth Sense Mobile!

PART 3. 구글의 눈으로 보는 세상

PART 4. 구글 in Science

뭔가 그럴듯해 보이는 아름다운 건축물을 해외여행 중에 보게 됐다면 어떤 건축물인지 궁금하다. 그런데 건축물 이름을 모르면 인터넷으로 찾기가 어려워진다.

구글 이미지 검색 ‘구글 고글스’는 사진이나 그림 속의 정보를 이용해 유사한 이미지나 이미지의 제목, 인물이나 모형의 정보를 바로 얻을 수 있다. 사진을 찍고 어떤 물체인지 찾아서 알려주는 똑똑한 ‘눈’이 되는 것이다.

사용자가 스마트폰으로 촬영한 이미지를 구글 데이터 센터로 전송하면 구글 시각 알고리듬 소프트웨어를 통해 이미지가 기호로 바뀐다.

이후 데이터 센터에 들어 있는 모든 이미지들과 픽셀(이미지를 구성하는 화소 단위), 색상, 재질 등을 비교한다. 이렇게 나온 정보는 얼마나 유아기기존 이미지와 비슷한지 계산한 뒤 검색 결과를 수 초 내에 보여준다. 만일 외국인이 경복궁에 있는 경회루에 방문해 기둥 하나만 사진으로 찍어 검색한다면 놀랍게도 ‘경회루’ 이미지가 검색결과로 제공될 수 있다.

휴대전화 하나만 들고 다니면 말을 들어주고 촉각도 느끼고 휴대전화가 본 장면에 대한 정보도 제공하는 세상이 구글 데이터 과학에 의해 펼쳐지고 있다.

▼관련기사를 계속 보시려면?

PART 1. 검색은 김수현(작가, 탤런트)을 구분할 수 있을까

PART 2. Sixth Sense Mobile!

PART 3. 구글의 눈으로 보는 세상

PART 4. 구글 in Science