경북 경산에 위치한 박한우 영남대 교수의 연구실에는 구석구석 컴퓨터가 숨어 있다. 연구원들이 쓰는 옆 방에도 본체 뚜껑을 연 컴퓨터들

이 가득하다. 마치 컴퓨터공학과 연구실 같지만, 이 곳은 인문대 신관 언론정보학과다.

“마침 오늘 오전, 내년에 발간될 저널에 투고한 논문이 통과됐다는 연락을 받았어요. 지난 서울시장과 교육감 선거 관련 데이터 연구입니다.”

박 교수는 사람들의 ‘속마음’을 밝혀내는 전문가다. 인터넷과 모바일 환경에서 만들어지는 다양한 빅데이터를 수집해 연관 관계를 밝혀낸다. 이미 싸이월드 방명록, 트위터 인맥, 국회의원 홈페이지, 전현직 대통령의 연설문 등을 분석했다(과학동아 2011년 2월호 ‘국회의원 인맥 찾는 소셜사이언스’ 참조).

이번에 실린 연구도 그 연장선상에 있다. 2010년 6월 2일 치러진 지방선거 당시 한명숙, 오세훈 후보의 대결로 뜨거웠던 서울시장 선거에 비해 교육감 선거는 큰 주목을 받지 못하고 있었다.

그런데 박 교수가 모은 데이터는 달랐다. 뉴스와 블로그, 트위터, 그리고 웹사이트 네트워크를 분석해보니, 교육감 선거의 관심도는 하루가 다르게 높아져갔다. 웹사이트 네트워크 수치는 일주일 만에 무려 45배나 높아졌다. 같은 기간 시장선거는 1.1배 늘어났다. 선거 당일 교육감선거가 큰 관심 속에 치러진 것은 물론이다.

박 교수는 최근 다른 데이터로 눈을 돌렸다. 유튜브다. ‘기후변화’라는 주제로 인기가 많은 영상을 10개 골라 찬성, 조건부 찬성, 반대 등 주제별로 분류했다. 그 뒤 댓글을 추출해 글을 쓴 사람들 사이의 네트워크를 추적했다. 유튜브는 문자 기반 SNS보다 데이터 양이 많고 의미의 폭도 넓다. 박 교수는 “똑같이 기후변화 정책에 찬성하는 내용이라도 영상에 따라 정도가 다르다”며 “이런 미묘한 차이가 댓글의 네트워크에 어떤 변화를 줄지 알 수 있을 것”이라고 말했다.

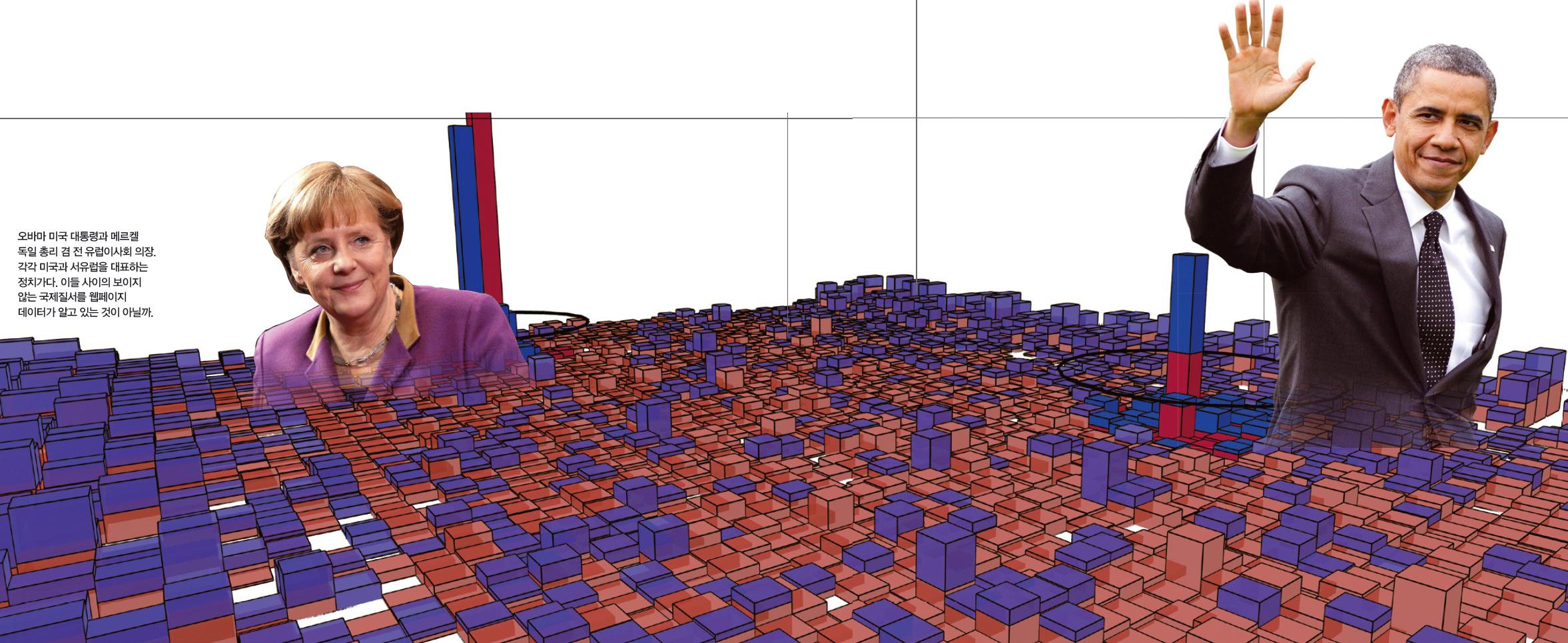

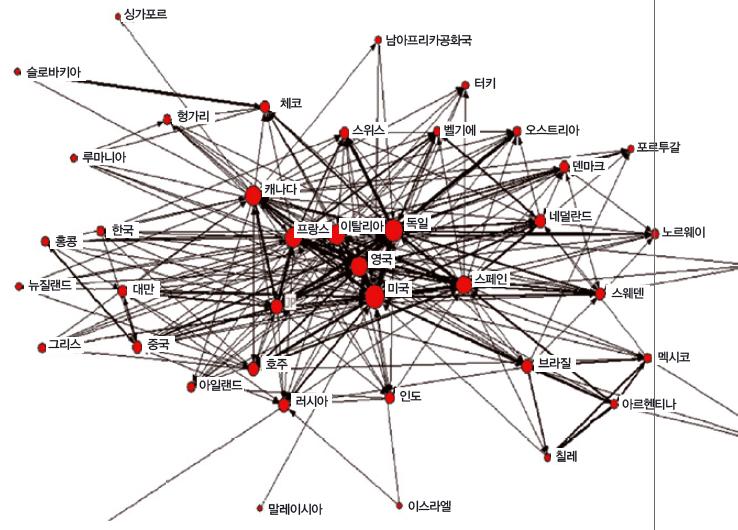

박 교수는 전 세계를 대상으로 한 빅데이터 연구도 놓치지 않았다. 2003년과 2009년 전 세계 웹페이지의 하이퍼링크(연결) 관계 변화를 분석한 연구가 대표적이다. 검색엔진 야후를 이용해 ‘.kr’, ‘.jp’ 등 국가 도메인 주소(273개)를 포함하는 웹사이트 338억 개의 연결 관계를 분석했다. 그 결과 미국, 일본 등 이른바 서방 선진 7개국(G7)과 스페인이 전 세계 웹의 중심에 위치하며, 집중도도 점점 심해지고 있다는 사실을 알 수 있었다. 박 교수는 “인터넷 사용량이 늘어난 것은 전 세계 공통이지만, 부유한 나라일수록 성장세가 더 컸다”고 설명했다. 적어도 웹에서는 영향력의 부익부 빈익빈 현상이 심해졌다는 뜻이다. 미국의 영향력이 줄고 서유럽의 영향력이 늘어난 것도 눈에 띄었다. 웹이 눈에 보이지 않는 국제 질서의 재편을 보여주는 게 아닐까.

글: 윤신영 기자

[오바마 미국 대통령과 메르켈 독일 총리 겸 전 유럽이사회 의장. 각각 미국과 서유럽을 대표하는 정치가다. 이들 사이의 보이지 않는 국제질서를 웹페이지 데이터가 알고 있는 것이 아닐까.]

[박한우 교수가 분석한 2009년 세계 웹페이지 네트워크 지도(위). 국가 도메인 사이의 하이퍼링크(연결) 관계를 이용했다. 각 노드(점)를 연결한 선이 굵을수록 서로 연결된 페이지가 많다는 뜻이며, 많이 연결된 나라들이 허브를 형성한다. 미국과 서유럽, 일본, 스페인 등이 중심을 이룬다. 2011년 ‘글로벌 네트워크’지에 실렸다.]

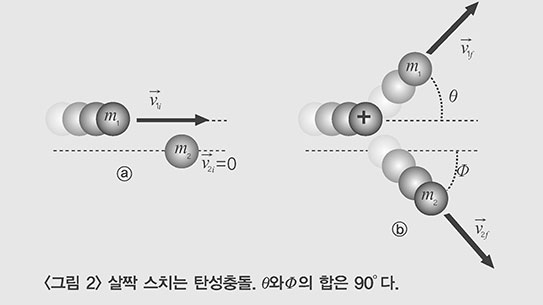

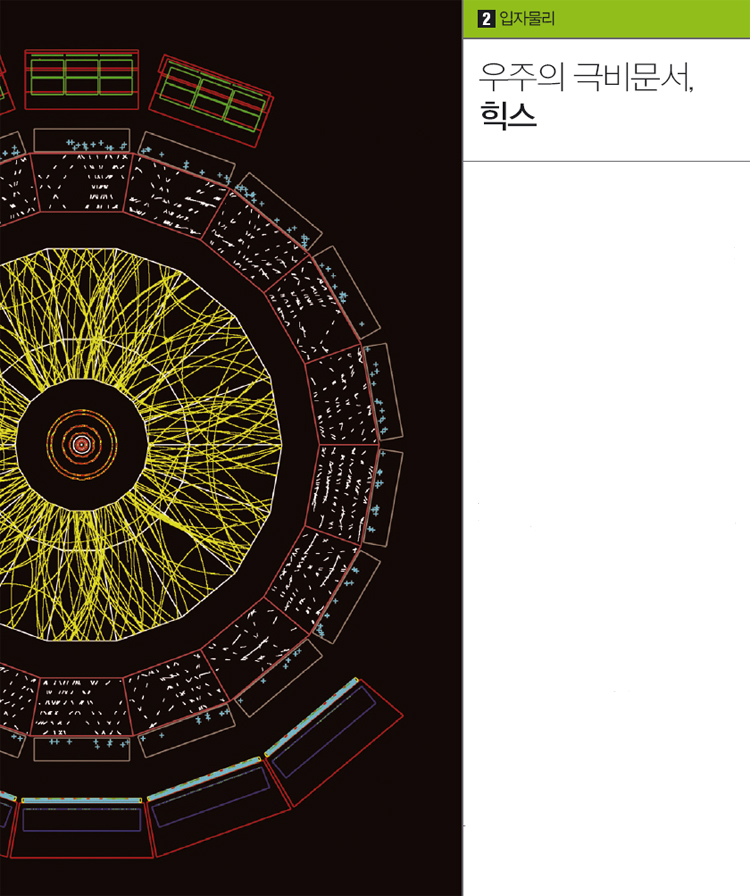

스위스 제네바 근처의 지하에 위치한 거대강입자가속기(LHC)는 2010년 3월부터 본격적으로 가동을 시작했다. 양성자와 양성자를 충돌시키는 실험을 하는데 이때 많은 입자가 만들어지고, 또 붕괴해 다른 입자를 만들어내는 일이 순식간에 일어난다. 이렇게 만들어진 입자들은 수천t이 넘는 검출기 안에서 전기 신호로 바뀌어 기록된다. 한 번의 충돌을 기록한 데이터는 약 2MB다.

양성자는 1초에 거의 1억 번 가량 충돌하기 때문에 여기서 만들어지는 데이터의 양은 상상을 초월한다. 그래서 데이터를 최대한 선별해서 기록한다. 대략 20만 번 충돌에 하나 정도가 기록된다. 그런데도 가동을 시작한 첫 1분 동안 기록된 데이터는 20GB나 됐다.

가속기가 본격적으로 성능을 발휘하면서 충돌 횟수는 빠르게 증가했다. 2010년 한 해 동안 LHC에서 나온 데이터의 총 양은 무려 13PB(페타바이트, 10억MB)에 달했다. CD에 기록해서 쌓아놓으면 에베레스트 산의 두 배 가까운 약 14km가 된다.

양자론에 따르면 ‘일어날 수 있는 일은 모두 일어난다.’ 그러므로 올바른 이론을 알고 있다면 모든 일이 일어날 확률을 계산할 수 있다. 예를 들어 힉스 입자가 만들어질 확률도 계산할 수 있다. 이 계산에 따르면 LHC에서는 2010년 한 해 동안 300개 정도가 만들어졌다. 기록된 수십억 번의 충돌 사건 중 300개의 사건을 찾으면 힉스를 발견할 수 있다.

확률로 본다면 해운대 모래밭에서 동전 하나를 찾는 일보다 더 어려운 일이다. 그래도 300개나 나왔다면 어쨌든 발견할 수 있지 않을까. 그렇지 않다. 만들어진 힉스 입자는 극히 짧은 시간에 붕괴해서 더 가벼운 입자를 만든다. 검출기에서 실제로 볼 수 있는 입자가 이들이다. 그러나 이 입자들은 대부분 다른 충돌 사건에서 나온 입자와 구별이 안 된다. 실제로 확인 가능한 것은 힉스 입자 100개 중 하나도 채 되지 않는다. 그래서 2010년 데이터로는 힉스 입자를 찾는 것이 불가능했다.

LHC는 데이터의 양을 늘렸다. 현존하는 가장 큰 빅데이터라 할 만하다. 이 데이터를 다루기 위해 물리학자들은 ‘그리드(Grid)’라고 불리는 컴퓨팅 기술을 사용한다.

그리드는 수많은 컴퓨터를 초고속 통신망으로 연결해 정보의 처리와 저장을 분산하는 기법으로, 저장장소와 CPU를 최대한 효율적으로 사용할 수 있다. LHC를 운영하는 유럽입자물리연구소(CERN)에서는 2002년부터 이그리드를 전 세계에 걸쳐 건설했다. 현재 수천 명의 물리학자들이 이를 통해 LHC 데이터를 연구하고 있다. 이처럼 언제 어디서나 연구자들이 자료에 접근할 수 있도록 하는 연구 방식을 ‘e-사이언스(e-science)’라고 한다.

2011년, LHC는 더욱 성능을 높여서 2010년 데이터의 약 150배에 달하는 데이터를 얻었다. 물리학자들은 이를 분석해 힉스 입자라고 여겨지는 흔적을 발견했다고 발표했다. 그러나 아직도 데이터의 양이 부족하다. 2012년 LHC는 다시 2011년의 3배에 달하는 데이터를 얻을

예정이다. 올해는 힉스 입자의 존재를 확인할 수 있을까.

실데나필은 가장 널리 알려진 약 중 하나다. 상품명이 비아그라인 이 약은 원래 심혈관 치료제였지만, 테스트 중 발견한 부작용을 살려 발기부전 치료제로 허가를 받았다. 해열진통제로 알려졌던 아스피린은 1980년대 심혈관 질환 예방에, 2000년대 중반 고환암과 췌장암 치료에 효과가 있음이 밝혀졌다.

이렇게 약물이 원래의 용도와 다른 질병에 사용되는 것을 ‘신약재창출(drug repositioning)’이라 한다. 최근 이 분야에 데이터에 기반한 네트워크 의약학이 도입됐다. 여러 가지 약학, 의학 데이터를 통합해 만든 네트워크를 분석해 약물을 사용할 수 있는 새로운 타깃이나 질병군을 발굴한다. 대표적인 예가 2006년 브로드연구소에서 만든 ‘연결도 지도’다. 1700종의 약물을 투약 용량을 바꿔가며 5종류의 세포주에 처리한 뒤, 그 효과를 측정해 구축한 데이터베이스다. 여기에 암 조직과 정상 조직을 대상으로 한 실험 결과를 입력하면 암 조직을 정상 조직으로 바꿀 수 있는 약물 후보 리스트가 나온다.

필자의 연구팀은 약물, 타깃, 질병 사이의 관계를 수집해 ‘팜디비(PharmDB)’라는 독자적인 네트워크를 만들었다. 페이스북에서 친구를 공유하는 두 친구는 서로 친구일 가능성이 높다. 약물도 마찬가지다. 여러개의 타깃을 동시에 가지고 있는 약물은 타깃에 공통적으로 연결된 질병에도 효과를 볼 가능성이 높다.

팜디비는 빅데이터다. 질병, 타깃, 약물 등으로 된 네트워크 노드가 5만6455개, 링크 31만 1156개 등 총 36만 7611개의 데이터가 있다. 연결 가능성이 있는 링크의 수를 따져보면 질병과 타깃, 약물과 타깃, 약물과 질병 등 모두 3억 8905만 1044개의 링크가 나온다. 모든 링크 값을 계산하고 저장하려면 최신 컴퓨터를 이용하더라도 하루가 넘게 걸린다. 더구나 100회 이상 반복해야 하니 데이터량은 상상을 초월한다. 네트워크 의약학은 다른 용도로도 활용된다. 많은 양을 쓸 때 나타나는 부작용을 줄이기 위해 비슷한 여러 약을 섞어 쓰는 ‘칵테일 요법’ 연구가 대표적이다.

[CERN의 중앙통제실. 물리학자들이 검출된 데이터를 보며 토론하고 있다.]

지난 3월 6일 세계의 시선이 미국 오하이오주에 쏠렸다. 미국 공화당의 가장 치열한 대통령 후보 경선이 열렸기 때문이다. 이 과정을 숨죽이고 바라본 곳 중 하나가 바로 트위터 본사다. 이곳의 ‘정부 및 정치’ 팀은 올해 초부터 경선 직전까지 후보의 이름을 언급한 트위터 문장을 실시간으로 모아 그 양을 시간대별 그래프로 그렸다. 이름이 언급된 문장은 많을 땐 한 사람당 하루 31만 건이 넘었다.

더 인상적인 것은 패턴이었다. 3월 6일로 올수록 롬니 후보와 샌토럼 후보의 데이터가 늘어났다. 두 후보의 각축전을 예상할 수 있었다. 실제 경선 결과는 예상과 정확히 일치했다.

선거는 후보자와 유권자 사이의 상호작용이다. 서로가 서로의 마음을 얻어야 하는 이 과정에서 데이터의 역할은 날로 중요해지고 있다. 특히 SNS와 모바일 환경의 성장, 많은 양의 데이터를 빠르게 수집하고 분석하는 기술의 발전이 큰 영향을 미치고 있다.

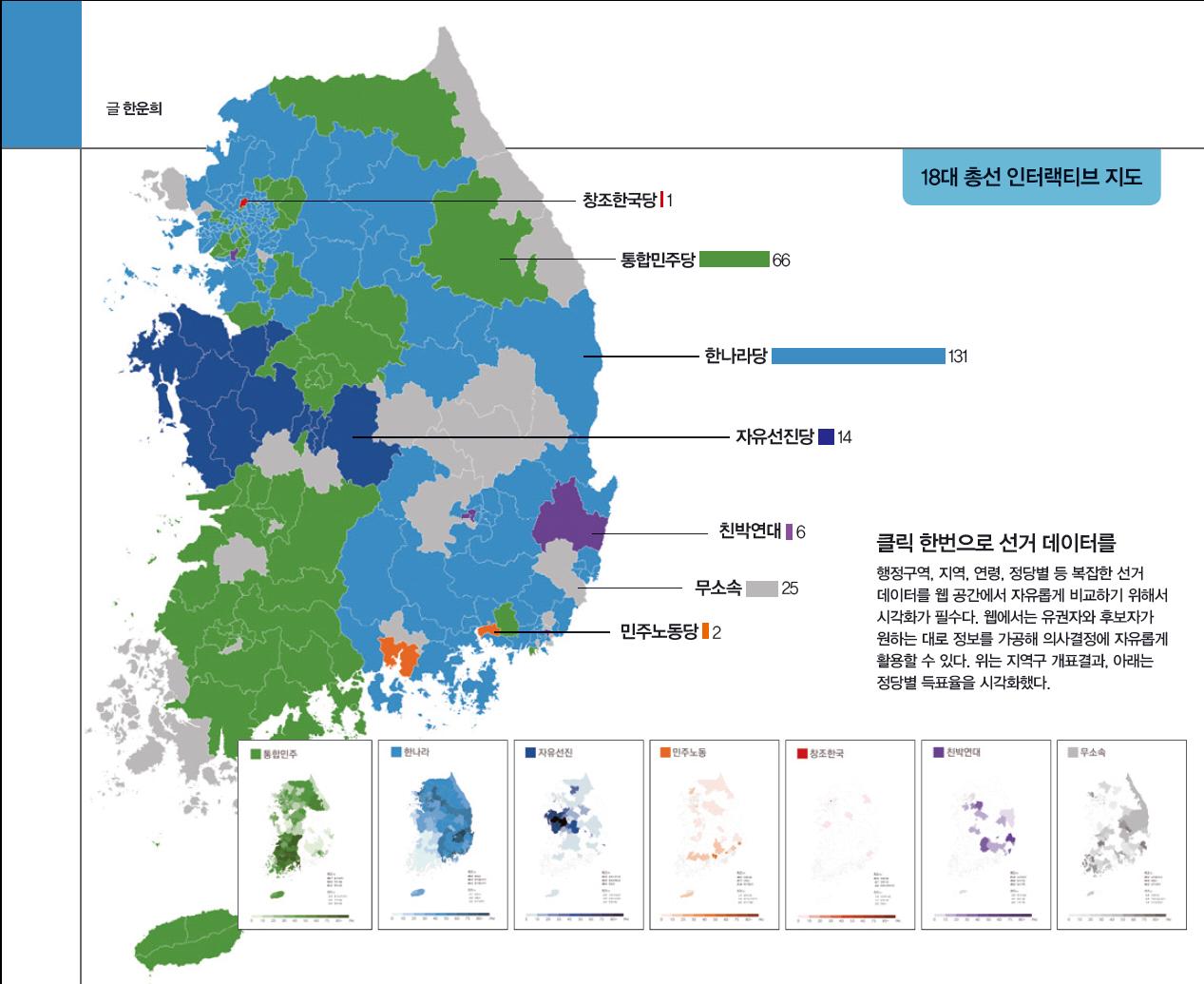

과거 선거 데이터의 정확한 분석은 데이터 기반 선거의 핵심이다. 우리나라는 중앙선거관리위원회에서 선거가 끝날 때마다 투표, 득표 데이터를 공개하고 있다. 하지만 각각 전국 1만 3167곳(17대)과 1만 3246곳(18대)의 투표소에서 2158만 1550명(17대), 1741만 5666명(18대)의 투표자가 만들어낸 선거 데이터는 대단히 복잡하고 방대하다.

데이터시각화는 데이터를 더 직관적이고 효율적으로 이해하고 활용하도록 돕는 방법이다. 대표적인 예가 필자가 속한 연합뉴스 미디어랩에서 만든 17, 18대 총선 인터랙티브(체험형) 데이터 지도다. 본격적으로 만든 국내 최초의 인터랙티브 선거 데이터 지도로, 정밀한 실제 지도에 지리정보시스템(GIS)과 대용량 선거 데이터를 연결해 만들었다.

데이터 기반 선거가 발달한 미국에서는 과거 자료 외에도 다양한 데이터가 선거에 활용되며, 시각화 사례도 풍부하다. ‘뉴욕타임스’는 2012년 미국 대선에 참여하는 모든 후보에 대해 선거 자금 규모, 모금 현황 등을 담은 복잡한 대용량 데이터를 시각화했다.

19대 총선부터 인터넷, SNS, 모바일 메신저 등을 이용한 사전 선거운동과 당일 투표 독려가 가능해졌다. 그 어느 해보다 선거 관련 빅데이터가 늘 것이다. 데이터 기반의 새로운 선거시대가 기대된다.

2010년 7월, 유통기업 ‘이마트’가 미국산 수입 쇠고기를 한우로 잘못 표기해 판매했다. 사람들은 이 일을 부정적으로 받아들였다. 당신이 CEO라면 어떻게 행동해야 할까. 사람들의 의견이나 감성을 파악할 수 있다면 보다 합리적인 판단이 가능하다. 여기에 이용될 수 있는 기술이 ‘의견 추출’ 또는 ‘감성 분석’이다. 여러 가지 글에서 의견이나 감성을 나타내는 어휘를 뽑아낸 뒤 자연어 처리 기술과 통계 기법으로 분석한다.

먼저 감정을 나타내는 단어들을 한데 모아 ‘단어장’을 구성한다. 그 뒤 단어장에 속한 어휘가 분석 대상 글에서 얼마나 자주 나타나는지 수치화해 그 글이 얼마나 긍정 혹은 부정적인지 알아낸다. 최근에는 특정 주제에 특화된 단어장이나, 이모티콘 분석이 가능한 단어장도 연구되고 있다.

감성 분석은 특히 트위터와 같은 SNS 데이터 분석에 유용하다. 개인은 물론 집단 단위의 분석이 가능하고, 시간에 따른 변화도 살펴볼 수 있다. 예를 들어 필자의 연구팀이 분석한 위 이마트 사례를 보자. 사건 발생 시점 전후로 ‘이마트’를 언급한 모든 트윗(5000여 건)을 다운로드해 감성을 수치화했다. 결과를 보면, 사건 직후 사용자들의 부정적인 감성이 평소보다 3배까지 급속하게 증가하다 CEO가 트위터를 통해 사과 성명을 발표하자 줄어들었다. 줄어드는 정도는 CEO를 구독(팔로)하는 사용자들이 그렇지 않는 사용자보다 같은 기간 내에 2배나 컸다. 평소 SNS를 사용하는 CEO의 신속한 사과가 부정적인 정서를 줄이고 회사의 피해를 막는 데 효과적임을 의미한다. 이렇게 데이터로 된 근거는 기업이 어떤 결정을 내리는 데 중요한 역할을 한다.

사건이 아닌 일반적인 글도 여러 예측이나 분석에 활용할 수 있다. 요한 볼른 인디애나대 교수는 미국의 트윗 약 100만 개를 수집해 6개의 감정으로 분류한 뒤 시간 별로 추적해, 미국 주가를 87.6%까지 정확하게 예측하는 데 성공했다. 마이클 메이시 코넬대 교수는 84개국 240만명의 트위터 데이터를 분석해, 긍정적인 감정과 부정적인 감정의 변화가 생체리듬과 관련이 있다는 사실을 밝혔다. 필자의 연구팀도 69명의 한국인 트위터 사용자의 트윗을 분석해 우울증에 걸리기 쉬운 사람일수록 부정적인 정서, 그 중에서도 특히 화와 관련된 표현 빈도가 높다는 사실을 확인했다.

▼관련기사를 계속 보시려면?

Intro. WELCOME TO 데이터유니버스

Part1. 왜 4할 타자가 사라졌을까

Part2. 2012 세상을 바꿀 빅데이터 5