마침 정치인의 감정을 추측하는 기사가 눈에 띕니다. 지난 7월, 시사주간지 ‘시사인’은 박근혜 전 대통령이 삼성의 경영권 승계를 도와줬다는 의혹과 관련한 문건을 찾았다고 말하는 박수현 청와대 대변인의 표정에 ‘0.36%의 기쁨과 0.3%의 경멸’이 있다고 분석했습니다. 표정분석기로는 마이크로소프트의 표정분석 API★ ‘이모션’을 쓴 것으로 보입니다. 이밖에도 박근혜 전 대통령과 이정미 전 헌법 재판관 등 유명인의 표정을 분석한 사례는 많았습니다.

마침 정치인의 감정을 추측하는 기사가 눈에 띕니다. 지난 7월, 시사주간지 ‘시사인’은 박근혜 전 대통령이 삼성의 경영권 승계를 도와줬다는 의혹과 관련한 문건을 찾았다고 말하는 박수현 청와대 대변인의 표정에 ‘0.36%의 기쁨과 0.3%의 경멸’이 있다고 분석했습니다. 표정분석기로는 마이크로소프트의 표정분석 API★ ‘이모션’을 쓴 것으로 보입니다. 이밖에도 박근혜 전 대통령과 이정미 전 헌법 재판관 등 유명인의 표정을 분석한 사례는 많았습니다.

API★ 개발자가 애플리케이션을 개발할 때 적용할 수 있도록 만든 인터페이스.

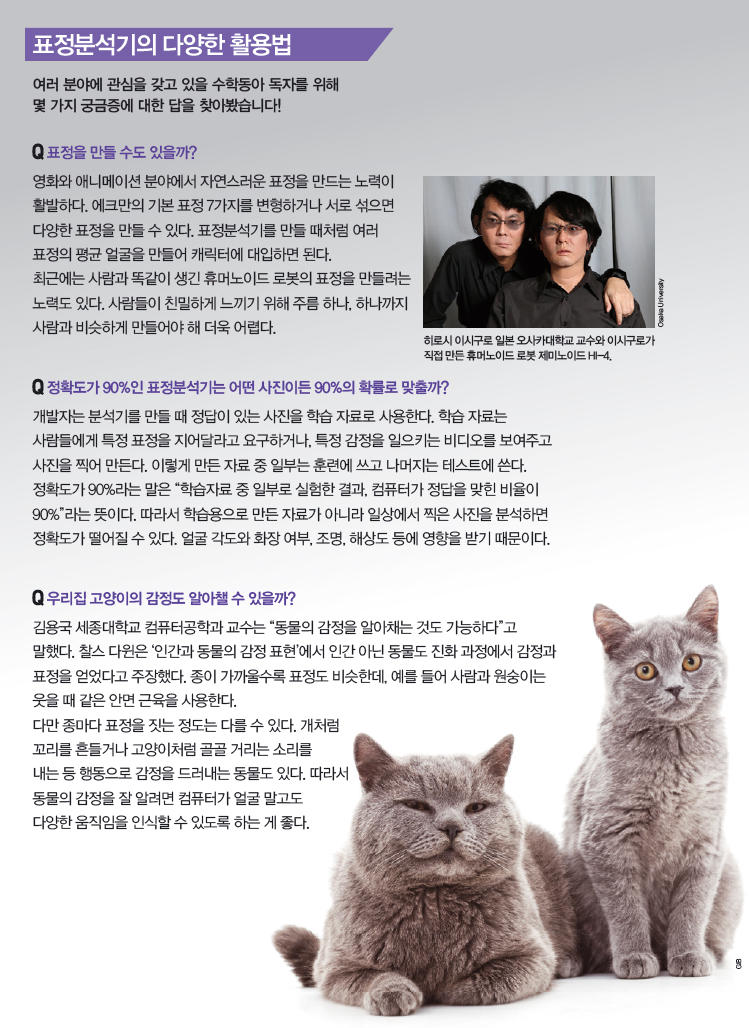

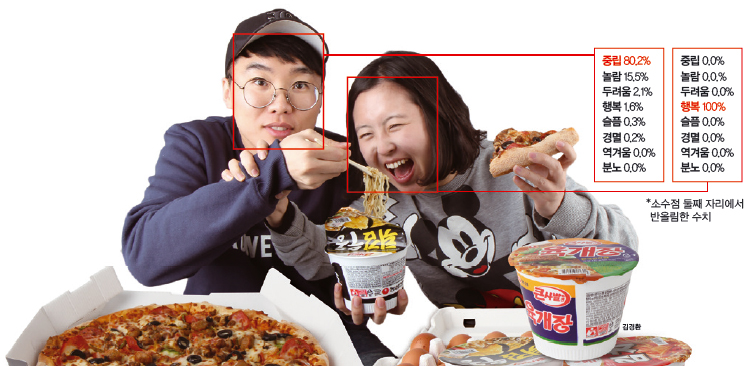

이모션 API 사이트는 누구든 체험할 수 있도록 데모버전을 제공한다.

이 기술이 믿을 만한지 시험해봤습니다. 실험 대상은 전 프로게이머 임요환과 홍진호. 둘은 ‘스타 크래프트: 리마스터’ 출시 기념 이벤트에서 2차례 승부를 벌였는데, 2인자로 유명한 홍진호 선수가 1차전에서 승리했습니다. 표정 분석 결과, 임요환 선수 표정에 행복 비율이 처음엔 44.8%였으나 패배한 뒤 1% 이하가 됐습니다. 추억의 게임을 즐길 생각에 행복했지만, 막상 지고 나니 그 마음이 사라졌다고 해석할 수 있겠습니다. 꽤 그럴듯합니다.

그런데 감정을 숨겼다면 어떨까요? 2017년 2월호에 실린 이다솔 기자의 사진을 봅시다. 이모션은 행복이 100%로 나타났다고 분석했지만, 당시 이 기자의 머릿속엔 ‘튀김 우동이 불어서 아깝다’와 ‘어서 원고 써야 하는데’라는 생각이 가득했습니다. 지금의 표정분석기로는 가짜 표정을 구별할 수 없었습니다.

표정분석기 대해부!

가짜 표정도 꿰뚫어 보는 표정분석기를 만들려면 지금 쓰이는 분석기의 원리부터 알아야 합니다.이모션을 포함한 표정분석기 대부분은 심리학자 폴 에크만의 이론을 바탕으로 합니다.

1970년대, 에크만은 표정이 세계적으로 보편적이며 문화권에 따라 다르지 않다는 찰스 다윈의 주장을 뒷받침하는 실험을 했습니다. 사람들에게 표정 사진을 보여주고 어떤 감정인지 맞히게 하거나, 특정 감정을 일으키는 이야기를 접하게 한 뒤 어떤 표정을 짓는지 관찰했습니다. 주요 문화권에 사는 사람뿐 아니라 그들과 교류하지 않는 파푸아뉴기니 원주민도 실험 대상에 포함 했죠.

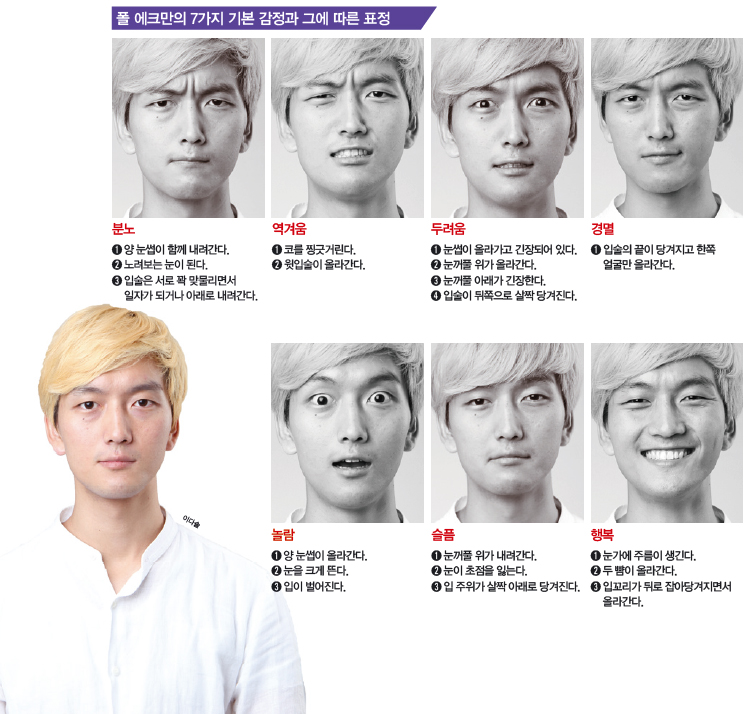

그 결과, 에크만은 보편적으로 나타나는 7가지 감정과 그에 따른 표정을 발견했습니다. 이것은 자라면서 학습하는 게 아니라 선천적으로 타고 나는 겁니다. 이 7가지 감정과 표정은 분노, 역겨움, 두려움, 경멸, 놀람, 슬픔, 행복입니다. 마이크로소프트의 이모션이 분류하는 표정의 종류와 같죠?

표정의 평균값으로 판단한다

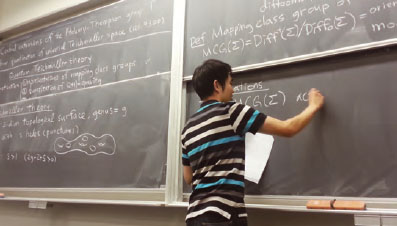

사람은 태어날 때부터 7가지 표정을 구분할 수 있지만, 컴퓨터는 그렇지 않아서 가르쳐야 합니다. 만약 100명의 표정 정보를 이용한다면 그들 모두에게 무표정과 7가지 기본 표정을 짓도록 해 사진을 찍은 뒤 학습 자료로 사용합니다.

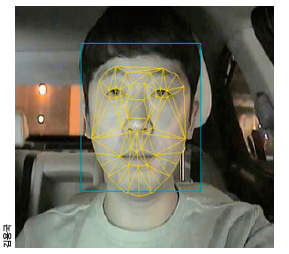

총 800장의 사진을 그대로 컴퓨터에게 입력하기에는 불필요한 정보가 많고 시간도 오래 걸립니다. 그래서 얼굴의 주요 부위에 점 수십 개를 찍어 컴퓨터가 이 점의 위치만 기억하도록 합니다. 눈썹의 끝점에는 1번 점을, 중간에는 2번 점을, 시작점에는 3번 점을 찍는 식입니다. 이렇게 점으로 바뀐 얼굴 정보를 ‘고유 얼굴’이라고 합니다.

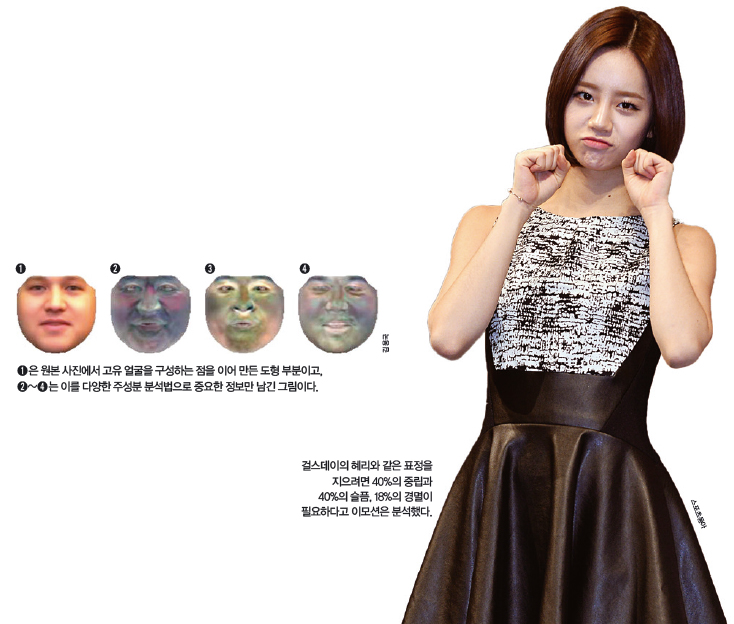

다음은 고유 얼굴에서 주요 특징을 뽑아낼 차례입니다. 이때 ‘주성분 분석법’을 이용합니다. 높은 차원의 정보를 낮은 차원의 정보로 줄이는 수학적 방법으로, 이 과정을 거치면 아래처럼 컴퓨터가 보기에 중요한 정보만 남습니다.

마지막으로 표정마다 정보의 평균값을 계산합니다. 이 값을 ‘평균 얼굴’이라고 합니다. 표정분석기는 분석 대상으로 입력된 얼굴을 무표정을 포함한 7가지 표정의 평균 얼굴과 비교합니다. 요즘엔 이런 과정에 기계학습을 도입해 정확도를 높이기도 합니다. 마이크로소프트의 이모션도 기계학습을 이용합니다.

이런 표정분석기는 진짜 감정을 읽기보다는 이 사람의 표정이 ‘어떻게 보이는지’를 인식한다고 보는 게 정확합니다. 자기의 표정을 교정하는 분야 같은 곳에서 더욱 유용하겠죠.

가짜 표정에도 안 속는다!

그렇다면 진짜 속마음은 어떻게 알아낼까요? 억지로 지은 표정에 속지 않는 방법도 에크만이 제안했습니다. 바로 ‘미세표정’입니다. 미세표정은 0.2~0.3초 사이에 순간적으로 나타나는 표정입니다. 사람이 인식하지 못하는 사이에 얼굴에 드러나기 때문에 거짓말을 할 수가 없다는 겁니다. 에크만에 따르면, 미세표정을 이용하면 10명 중 8명의 거짓말을 알아낼 수 있습니다.

2015년, 핀란드 오울루대학교 연구팀이 미세표정을 인식하는 인공지능 알고리즘을 만들었습니다. 연구팀은 사람들에게 감정을 일으킬 비디오를 보여주고 어떤 표정도 짓지 말라고 요구했습니다. 그리고 이를 초고속 카메라로 찍어 미세표정 이미지를 얻은 뒤 컴퓨터에게 학습시켰죠.

이제 컴퓨터가 스스로 미세표정을 찾을 차례입니다. 컴퓨터는 분석하려는 사람의 무표정한 얼굴을 다른 모든 프레임★과 비교해 둘의 차이가 특정 값보다 크면 그 프레임을 미세표정으로 판단 했습니다. 이 미세표정이 어떤 표정인지 판별할 때, 연구팀은 작은 차이를 잡아내는 방법인 ‘오일러리안 영상 확대법’을 사용해야 했습니다. 사람이 감정을 드러내지 않으려 할 때 미세표정은 무표정과 차이가 크지 않기 때문입니다. 연구팀은 컴퓨터가 미세표정을 찾는 능력이 사람과 비슷했다고 밝혔습니다. 더 많은 학습 데이터를 모은다면 성능이 좋아질 겁니다.

프레임★ 움직이는 영상을 구성하는 정지된 이미지들 중 한 장.

하지만 이 알고리즘도 한계가 있습니다. 무표정이 아닌 다른 표정을 억지로 짓는 사람의 가짜 표정은 구분해내지 못하기 때문입니다. 그래서 표정 종류에 관계없이 가짜표정을 구분해내는 연구도 진행 중입니다. 마이크로소프트는 올해 처음으로 가짜 표정과 진짜 표정을 잘 구별하는 컴퓨터를 뽑는 대회를 국제컴퓨터비전학회에서 열었습니다. 정확도가 높아진다면 수사현장에서도 사용할 수 있겠죠?