중국 인공지능(AI) 스타트업, 딥시크가 잔잔한 AI의 바다에 커다란 파문을 일으켰다. 푸른 고래가 어떤 파도를 일으켰고, 이것이 한국에 주는 메시지는 무엇인지 살펴봤다.

세상을 뒤흔든 파란 고래, 딥시크가 뭐야?

딥시크(DeepSeek)는 중국 인공지능(AI) 회사 이름입니다. 그리고 이 회사가 만든 AI 모델의 이름이기도 합니다. 2025년 1월 25일, 딥시크가 선보인 모델, ‘딥시크-R1’이 전 세계를 떠들썩하게 만들었습니다. 딥시크는 R1이 OpenAI의 대규모언어모델(LLM)인 ‘o1’과 비슷한 성능을 보였다고 발표했습니다. o1은 추론 능력이 특화된 AI 모델로 2024년 12월에 출시됐습니다. R1이 o1과 경쟁할 만한 성능이라는 점은 큰 화젯거리가 됐습니다. R1은 o1보다 훨씬 낮은 사양의 반도체를 사용해 매우 적은 비용으로 구현됐기 때문입니다.

R1을 어떤 반도체, 얼마로 개발했는데?

딥시크는 R1의 기반이 된 LLM인 ‘딥시크-V3’ 개발비가 557만 6000달러(한화 약 80억 원)이라고 밝혔습니다. OpenAI의 GPT-4 개발비(약 7800만 달러, 한화 약 1조 1336억 원)의 7% 수준입니다. OpenAI는 o1 개발 비용을 공개적으로 밝히지 않았지만, 직관적인 예측 방식을 사용하는 GPT 시리즈와 달리 o1은 깊은 사고를 통해 정확도를 높였기에, 모델 사용료가 GPT-4o의 6배입니다.

LLM엔 큰돈이 듭니다. LLM을 학습시키고 운영하려면 많은 양의 연산을 해낼 수 있는 고성능 하드웨어가 필수죠. 보통 그래픽처리장치(GPU)나 텐서프로세싱유닛(TPU) 등이 사용됩니다. 고급 GPU는 가격이 한 대당 약 4000~6000만 원 수준인데 AI 연구소는 수천~수만 GPU를 클러스터로 연결해 모델을 학습시킵니다. 그뿐인가요. 학습에 필요한 데이터를 수집하고 정제하는 과정, 만든 모델을 최적화하고 개선하는 과정 모두에 막대한 돈이 듭니다.

딥시크가 발표한 개발 비용은 파격적으로 낮았습니다. 모델을 개발할 때도 저사양의 GPU를 약 2000개만 썼다고 밝혔고요. 때문에 R1이 발표된 후 세계 반도체 주가가 급락하기도 했습니다. 지금까지는 단순한 연산을 동시에, 빠르게 해내는 데 특화된 반도체의 성능이 곧 AI 모델의 성능과 직결됐지만, 앞으로는 이런 값비싼 반도체 없이도 고사양의 AI 모델을 만들 수 있다는 기대감의 결과였습니다.

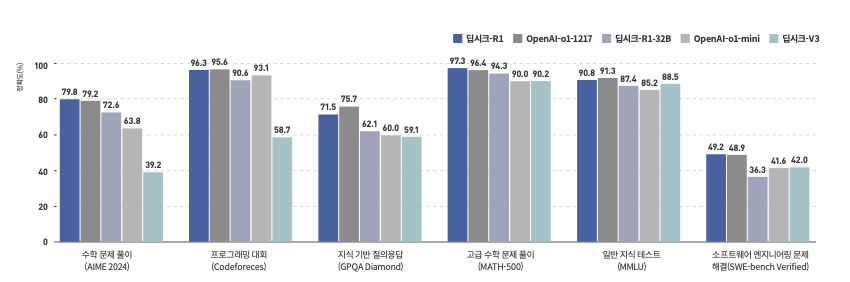

딥시크 vs. OpenAI 추론 능력 비교

아니, 어떻게 개발 비용을 줄였대?

딥시크는 전문가 혼합(MoE・Mixture of Experts) 기법과 8비트 부동소수점(FP8) 연산을 채택해 모델 개발 비용을 줄일 수 있었다고 설명했습니다.

MoE는 여러 전문가 모델을 활용해 모델의 효율성과 성능을 향상하는 방법입니다. 쉽게 말해 여러 명의 전문가를 두고, 입력마다 가장 적합한 전문가를 활용하는 겁니다. 기존 단일 모델은 한 명의 전문가가 모든 분야의 질문에 대답하는 구조였습니다. 그러다 보니 이 전문가로 AI를 학습시키는 과정에도, 이 전문가가 답변을 만들어내는 데도 오랜 시간과 큰 비용이 필요했죠. MoE는 여러 신경망을 두고, 질문에 따라 적합한 답을 만들어 낼 수 있는 신경망 몇 개만 활성화합니다.

FP8은 연산량과 메모리 사용량을 줄이고자 도입된 숫자 연산 방식입니다. 부동소수점은 소수점이 자유롭게 이동할 수 있는 숫자 표현 방식인데, 작은 메모리로 더 넓은 숫자 범위를 표현할 수 있습니다. FP8은 8비트로 숫자를 표현해 신경망 학습과 추론에 필요한 메모리 사용량을 줄일 수 있죠. 딥시크는 FP8을 사용해 FP32 사용 대비 메모리 사용량을 75% 절감할 수 있었습니다. 앞서 2022년 9월, 엔비디아, 암, 인텔 등 반도체 3사는 FP8을 새로운 표준 형식으로 제안하기도 했습니다.

저렴한 건 알겠어. 그런데 성능은 어떻게 높였어?

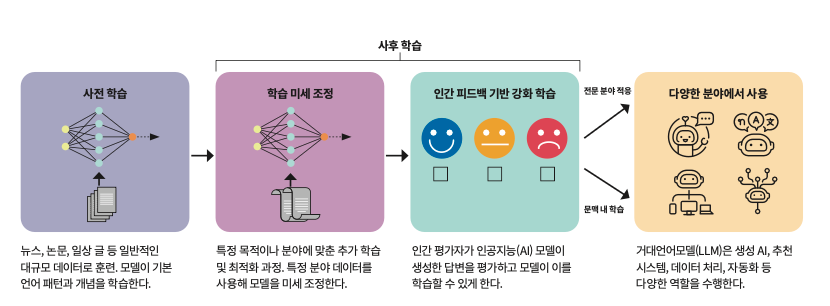

딥시크는 강화 학습, 콜드 스타트 데이터, 지식 증류 등 다양한 방식을 결합해 성능을 높였습니다. 우선 딥시크는 R1을 개발하며 강화 학습만을 사용한 사후 학습으로 AI의 추론 능력을 크게 높일 수 있음을 입증했습니다. LLM 훈련 과정은 사전 학습과 사후 학습으로 나눌 수 있습니다. 사전 학습은 대량의 데이터를 사용해 모델이 언어의 패턴을 학습하는 단계며, 사후 학습은 모델의 성능을 개선하기 위해 추가적인 학습을 진행하는 단계죠.

사후 학습에선 더 나은 답변을 생성할 수 있도록 모델을 미세 조정합니다. 일반적으로 사후 학습은 지도 학습과 강화 학습의 조합으로 이뤄집니다. 지도 학습은 모델에 정답을 주고 ‘자, 이렇게 대답해야 한다’고 알려주는 방식이며, 강화 학습은 모델이 답변한 것을 인간이 ‘이게 가장 좋은 대답이야’라고 평가하는 방식이죠. 모델은 이런 평가를 통해 좋은 답변이 무엇인지 알아가게 됩니다. 강화 학습만으로 더 좋은 답변을 이끌어낼 수 있단 건, 모델이 스스로 어떻게 사고하고 문제를 풀어야 하는지 학습할 수 있다는 뜻이니 주목할 만합니다. 앞으로 사람이 직접 학습에 개입하는 비용이 줄어들 테니 개발비 절감도 가능하겠죠. 다만 R1은 더 좋은 성능을 내기 위해 여기에 학습 미세 조정(SFT) 데이터와 다단계 학습을 추가했습니다.

딥시크는 모델에 사전 학습 단계 전에, ‘몸 풀기’ 단계를 먼저 거치게 했습니다. 대량의 데이터를 학습시키기 전 소량의 고품질 SFT 데이터를 먼저 학습시킨 겁니다. 이렇게 초기 학습 문제를 해결하기 위해 사용하는 고품질 데이터를 콜드 스타트 데이터라 부릅니다.

본격적인 강화 학습을 하기 전에 SFT를 먼저 학습시키면 모델의 기초 성능을 높이고, 그 결과 추론 성능과 수렴 속도를 끌어올릴 수 있습니다. OpenAI나 구글 딥마인드 등도 모델 개발에 사용하고 있는 방식입니다.

한편 지식 증류란 대형 모델의 추론 능력을 소형 모델로 전달해, 작은 모델의 효율성과 성능을 높이는 기법입니다. 딥시크는 R1 모델이 R1-zero 모델의 지식을 증류해 개발됐다고 밝혔습니다. R1-zero는 V3에 강화 학습을 적용한 모델이었죠. GPT-4를 모바일로 이용하기 위해 개발된 GPT-4 Mini도 지식 증류 기법으로 개발됐습니다.

거대언어모델(LLM) 훈련 방식

완전히 새로운 기술은 없어 보이는데…

그렇습니다. 딥시크는 이미 AI 연구 및 산업계에서 검증된 기술을 잘 버무려 탄생한 모델입니다. 그런 점에서 딥시크는 ‘아이폰’에 비유되기도 합니다. 아이폰이 등장하기 전에도 터치 기술, 디스플레이 기술, 사용자 인터페이스(UI) 기술은 모두 존재했습니다. 애플은 이런 기술을 정교하게 결합하고 최적화해 아이폰을 탄생시켰고, 아이폰은 결국 스마트폰 혁신의 아이콘이 됐습니다. 딥시크 역시 기존 AI 기술을 융합해 AI 모델의 새로운 기준을 제시하고 있습니다.

딥시크는 한국이 AI의 시대에 어떤 모델을, 어떻게 개발할 수 있을지에 대한 힌트가 될 수 있습니다. OpenAI, 구글 딥마인드, 마이크로소프트 등 이미 자본과 기술을 선점해 초거대 AI 모델을 개발한 주요 기업과 ‘강 대 강’으로 부딪히는 건 불가능합니다. 하지만 이미 있는 재료로 요리를 잘하는 것만으로도 이들과 경쟁이 가능하다는 것이 딥시크를 통해 증명됐습니다.

딥시크의 정보 유출을 걱정하기도 하던데?

딥시크에 입력한 정보와 모델에 접속한 기기 정보가 중국 서버에 저장된다는 게 알려지면서 딥시크 사용을 제한하는 움직임이 있었습니다. 중국이 자국 내 법에 따라 자국 기업이 가진 민간 데이터를 요청해, 볼 수 있기 때문입니다. 한편 한국 정부는 딥시크가 개인정보 보호법을 위반하는 부분을 확인해 2월 15일부터 딥시크 앱 다운로드를 중단했으며, 기존 사용자에게도 이용을 자제해 달라고 당부했습니다.

하지만 AI 제공업체의 서버에서 모델을 실행하고 API를 통해 사용하는 ‘오픈(open)’ 방식이 아닌, ‘온프레미스(on-premise)’ 형태로 모델을 사용한다면 정보 유출을 걱정하지 않아도 됩니다. 온프레미스 형태는 모델의 코드를 다운로드하고, 자신의 클라우드에서 실행하는 방식입니다. 딥시크는 자사의 모델을 오픈소스로 공개했기 때문에 누구나 모델 코드를 가져올 수 있죠. 딥시크는 R1을 MIT 라이선스 하에 공개해 누구나 자유롭게 사용하고 수정할 수 있게 했습니다. 만약 한국 AI 서비스 회사들이 R1을 온프레미스 형태로 가져와서 서비스 기능을 개선시킬 경우, 정보 유출 우려없이 사용할 수 있습니다.

딥시크는 왜 오픈소스로 풀었을까?

AI 연구 및 산업계에서는 본래 소스코드를 모두 공개해 왔습니다. 소스코드를 공개해야 다른 사람들이 재현해 볼 수 있고, 성능을 인정받을 수도 있기 때문입니다. 하지만 OpenAI는 GPT-3부터 모델의 소스코드와 학습 데이터를 비공개로 전환했습니다. AI 모델을 기업의 사업 모델로 삼으면서부터입니다.

딥시크가 모델의 코드를 전부 공개한 것은 홍보 때문이라는 말이 있습니다. AI 연구자들이 코드를 확인하며 모델을 검증 및 사용하는 과정에서 크게 홍보가 되니까요. 최근 들어 적은 자원으로 좋은 성능을 내는 AI 모델이 여럿 출시되고 있습니다. 2023년에 설립된 프랑스 AI 연구 및 개발 스타트업 미스트랄AI가 공개한 ‘미스트랄 7B’ 모델도 그중 하나입니다. 7B는 70억 개라는 상대적으로 적은 파라미터 수로 강력한 성능을 자랑하죠. 이런 미스트랄 7B도 오픈소스로 공개됐습니다.

앞으로는 또 어떤 AI 대란이 올까?

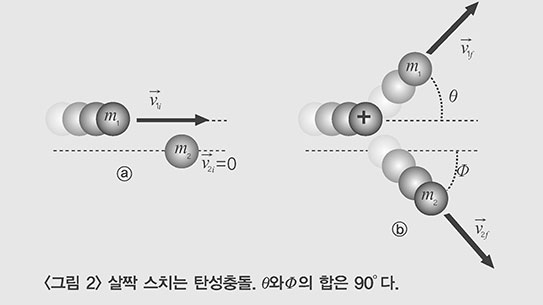

아직도 AI는 ‘트랜스포머’가 장악하고 있습니다. 트랜스포머는 구글이 2017년에 제안한 신경망 모델입니다. 주요 AI 모델은 물론 딥시크 역시 트랜스포머 모델을 기반으로 만들어졌죠. 트랜스포머 모델은 모든 입력을 동시에 처리할 수 있어 연산 속도가 매우 빠르다는 특징이 있습니다. 그리고 이런 트랜스포머 모델의 빠른 연산 속도를 구현하는 게 바로 반도체입니다. GPU나 TPU 같은 반도체가 수천 개의 코어를 병렬로 연산할 수 있기 때문입니다.

특히 트랜스포머 모델을 기반으로 LLM을 만들기 위해서는 반도체가 필수입니다. LLM은 수십 억~수천 억 개의 파라미터를 저장하고 계산해야하는데 이때 대량의 메모리와 고속 연산이 필요하죠. 이런 이유로 딥시크 발표 이후 급락한 반도체 주식은 다시 반등했습니다. 언젠가 트랜스포머가 아닌, 다른 방식으로 LLM을 만드는 기술이 제안되고, 그 방식이 트랜스포머보다 성능이 더 좋다고 인정되면 그땐 진정으로 AI 패러다임의 변화가 이뤄질 겁니다.