리니지 같은 온라인 게임을 할 때 화면 속 주인공은 2차원 평면 모니터 속의 가상 인물일 뿐이다. 하지만 3차원 입체음향 기술을 이용하면 게임을 하는 사람의 앞과 뒤, 옆에서 온라인 캐릭터들이 직접 움직이는 것처럼 들린다. 게임 속에 들어와 있다는 느낌도 커진다.

KAIST 기계공학과 구조동역학 및 응용제어 연구실의 박영진 교수는 사람들이 가상공간에서 소리를 3차원적으로 느낄 수 있는 ‘3차원 입체음향’ 기술을 연구하고 있다.

3차원 소리 만드는 ‘머리전달함수’

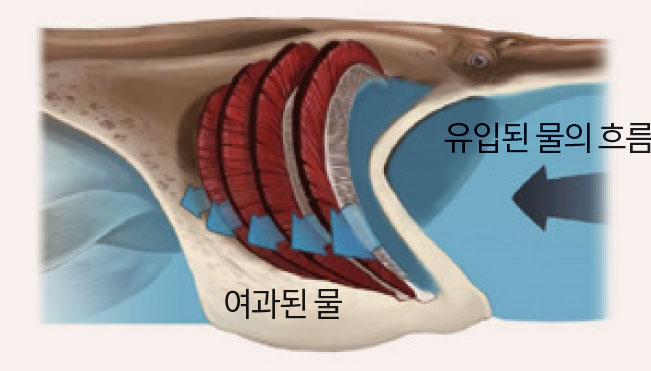

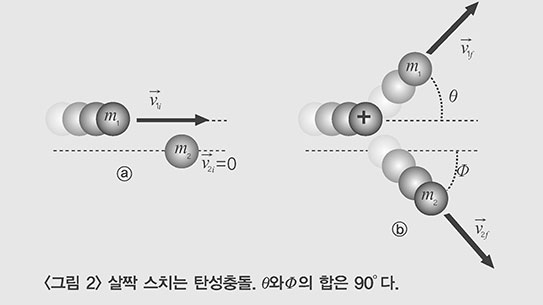

사람은 어떻게 왼쪽에서 나는 소리와 오른쪽에서 나는 소리를 구분할까. 우리는 소리를 두 귀로 인식한다. 이때 왼쪽에서 발생한 소리는 왼쪽 귀에 먼저 도달한다. 즉 소리가 양쪽 귀에 도달하는데 걸리는 시간차 때문에 소리의 방향을 알 수 있다.

또 귀에서 각각 앞뒤로 1m 떨어진 곳에서 같은 소리가 나도 귀에 도달할 때는 서로 다르게 들린다. 뒤에서 오는 소리는 귓바퀴에 부딪혀 소리의 진폭이 낮아져 소리가 작게 들리기 때문이다.

“게임 속 주인공이 오른쪽에서 총을 쏜다고 하자. 스피커는 앞에 있으므로 소리는 앞에서 들린다. 그런데 오른쪽에서 들려오는 총소리를 만들 수는 없을까?”

박 교수는 “가능하다”고 말한다. 소리의 진동수와 사람 귀에서 음원까지의 거리를 이용한 함수(머리전달함수)를 만들면 된다. 연구팀은 마네킹의 양쪽 귀에 마이크를 붙이고 음원의 거리와 위치를 다르게 조절하면서 소리를 냈다.

음원과 귀까지의 거리, 소리의 진동수를 측정하고 마네킹의 마이크에서 들리는 소리의 세기를 측정한 뒤 ‘머리전달함수’를 계산했다. 같은 진동수의 소리라도 주파수마다 진폭과 시간차를 다르게 하면 앞에서 들리는 소리도 옆에서 들리는 소리로 바꿀 수 있다. 이것이 박 교수가 개발한 ‘3차원 입체음향시스템’의 원리다.

3차원 입체음향은 현재 시판되는 홈시어터 5.1 채널로 즐길 수 있다. 여기에는 스피커가 정면에 하나, 앞 뒤 각각 좌우에 1개씩 모두 5개다. 박 교수팀은 3차원 입체음향효과를 재현하는데 필요한 스피커의 수를 줄였다. 연구팀은 스피커 2개만으로 3차원 입체음향을 느낄 수 있을 뿐 아니라 이전에는 재현하기 어려웠던 저음까지도 완벽히 재생시켰다.

앉았다 일어나거나 움직이면서 소리를 듣는 것은 가만히 앉았을 때 듣는 소리와 다르다. 예를 들면 처음엔 감쪽같던 입체음향도 고개를 돌리거나 자세를 바꾸면 그 효과가 줄어든다. 사람마다 귓바퀴의 모양이나 체격 조건이 다르기 때문이다.

왼쪽에서 소리가 들릴 때 얼굴이 넓적한 사람과 길쭉한 사람이 오른쪽 귀로 듣는 소리는 다르다. 소리가 이동하는 경로가 서로 다르기 때문이다. 연구팀은 이점을 고려해 ‘맞춤형 머리전달 함수’를 개발하고 있다. 맞춤형 머리전달 함수를 입체음향 기계에 넣으면 내 체형에 맞는 풍부한 3차원 입체음향을 들을 수 있다.

로봇과 교감하는 음향기술

이 기술은 로봇용 귀를 만드는데도 응용된다. 거실에 있는 청소 로봇에게 “이리 와!”하고 부르면 로봇은 어디로 오라는지 고민할 것이다. 하지만 소리가 어느 곳에서 왔는지 추적할 수 있는 귀를 가진 로봇은 소리의 방향과 세기를 분석해 주인이 부르는 곳으로 갈 것이다. 이제 현관에 들어서며 로봇을 부르거나 목욕을 하며 시원한 주스를 로봇에게 부탁할 수도 있지 않을까.

어릴 적부터 로봇을 만드는 것이 꿈이었던 박사과정 황성목 연구원은 “미래의 로봇은 우리의 친구가 돼 줄 거예요”라며 “어느 곳에서 누가 부르는지 인식하는 로봇과 학교에서 있었던 일을 이야기하며 웃는 날이 머지않다”고 말한다.