숙제할 때 생성형 인공지능(AI)을 사용하니? 그런데 때때로 생성형 AI가 잘못된 정보를 알려줘서 곤란했던 적 있을 거야.

AI가 지어내는 거짓말을 알아낼 방법은 없을까?

AI의 말, 전부 사실은 아니다

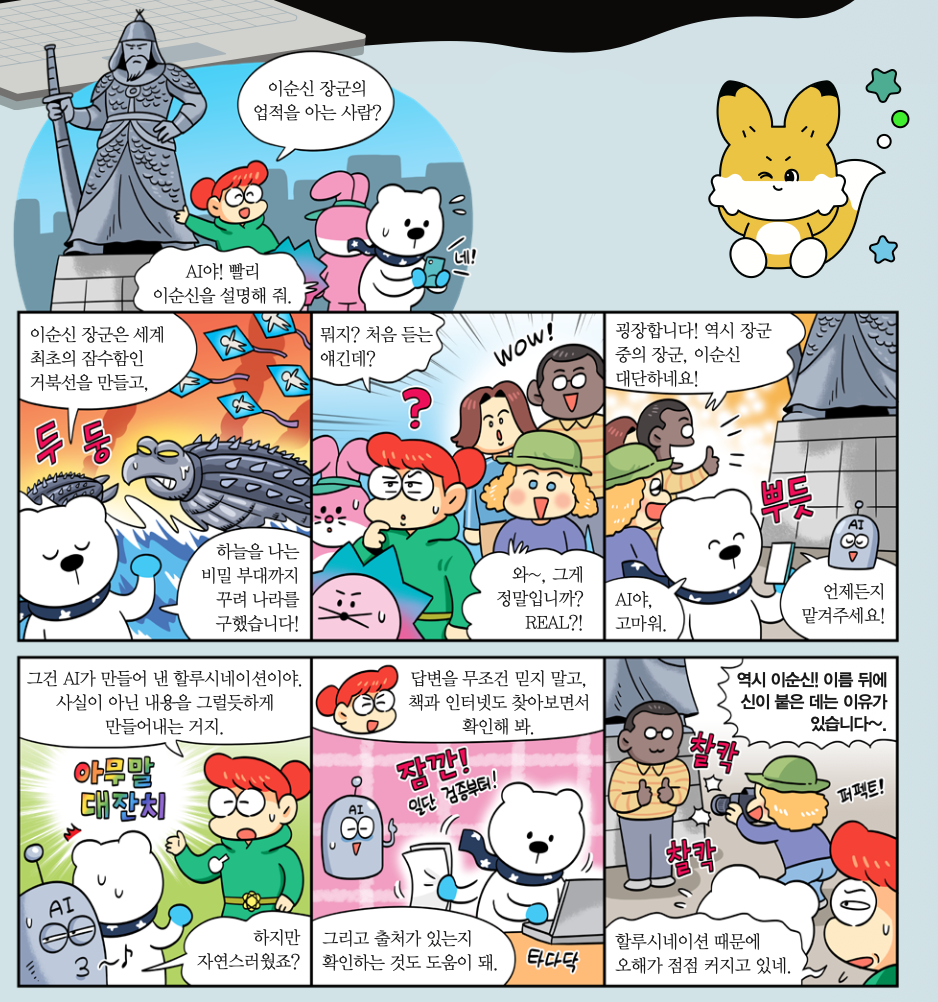

이순신 장군에 대한 발표를 준비하던 민수는 책을 읽거나 선생님께 질문하는 대신 생성형 인공지능(AI)에 이순신 장군의 업적을 물어봤어요. 그리고 AI가 알려준 내용과 출처를 그대로 받아 적었지요.

다음날, 민수는 손을 번쩍 들고 발표했습니다. “이순신 장군은 조선 시대의 뛰어난 발명가였어요. 거북선뿐 아니라 나침반도 발명했지요. 임진왜란 때 나침반으로 거북선의 방향을 조종했어요. 이 내용은 <이순신과 그의 업적>이라는 책에 나와요.”

하지만 민수의 발표를 들은 선생님과 친구들이 이상한 표정을 지었어요. 억울해진 민수는 “생성형 AI에 물어봤다”고 말했지요. 그러자 선생님은 “민수야, <이순신과 그의 업적>이라는 책은 존재하지 않아. 아마 할루시네이션 때문인 것 같아”라고 알려줬어요.

요즘 민수처럼 궁금한 내용이나 숙제 답을 생성형 AI에 묻는 어린이가 많아요. 생성형 AI에 질문하면 모르는 내용을 몇 초 안에 자세히 알려줘요. 포털 사이트에 검색해도 ‘AI 요약’이 가장 먼저 보이기 때문에 검색한 내용을 편리하게 찾을 수 있어요.

생성형 AI를 사용하면 ‘할루시네이션(Hallucination)’이라는 함정에 빠질 수 있어요. 할루시네이션은 AI가 거짓 정보를 그럴듯하게 꾸며 내는 현상이에요. 생성형 AI는 세상에 없는 책, 논문을 출처로 제시하기도 해요.

2025년 11월 일본에서는 AI가 ‘먹어도 안전하다’고 판단한 버섯을 먹었다가 알고 보니 독버섯이어서 응급실에 실려 간 사례도 있었어요. 이처럼 생성형 AI를 정보 검색 도구로 쓰기에는 아직 위험해요. 2025년 11월 26일, 미국 캘리포니아주 소속 검사가 AI로 법원의 이전 판례를 찾아봤는데, 알고 보니 거짓 판례여서 문제가 발생하기도 했어요. 어린이뿐 아니라 어른들도 할루시네이션에 빠질 수 있답니다.

할루시네이션에 속지 않으려면?

생성형 AI는 왜 사실과 다른 내용을 그럴듯하게 포장해서 알려줄까요? 그 이유는 챗GPT와 구글 제미나이 같은 생성형 AI가 정보 검색용으로 만들어진 기술이 아니기 때문이에요. 생성형 AI의 목표는 정확한 답을 내놓는 게 아니라, 질문과 가장 어울리는 단어를 조합해 자연스러운 문장을 완성하는 것이에요. 그래서 겉보기에는 완벽한 내용처럼 보여도, 자세히 보면 사실과 완전히 다른 내용을 말하기도 해요. 심지어 존재하지 않는 책이나 논문 제목을 지어내 출처라고 알려주기도 합니다.

그럼에도 생성형 AI가 인터넷 검색, 책 읽기보다 더 유용할 때도 있습니다. 두 개념의 관계를 알고 싶거나 복잡한 내용을 쉽게 풀어서 설명할 때는 생성형 AI가 더 나은 답변을 내놓기도 해요. 수백 페이지가 넘어가는 문서의 핵심 내용을 빠르게 요약할 때도 유용하지요. 또 외국어로 쓰인 웹사이트나 문서를 우리말로 번역할 때도 쓸 수 있어요. 이처럼 상황에 맞게 사용하면, 생성형 AI를 슬기롭게 활용할 수 있습니다.

생성형 AI가 만들어 내는 할루시네이션에 어떻게 대응해야 할까요? 첫째, 교차 확인을 해야 합니다. 생성형 AI가 알려준 내용을 구글, 네이버 같은 검색 엔진에 찾아보거나 관련 책에서 읽으며 비교해 보세요. 이때 한 곳에서만 확인하지 말고, 두 군데 이상에서 내용을 점검하면 훨씬 정확하게 AI가 설명한 내용이 진실인지 판단할 수 있습니다.

둘째, 출처가 실제로 존재하는지 확인해 보세요. 민수의 경우 도서관이나 서점 홈페이지에서 <이순신과 그의 업적>이라는 책이 있는지 살펴봤다면, 엉뚱한 내용으로 발표하지 않았을 거예요. 실제로 존재하는 자료라도, 해당 출처가 믿을 만한 곳인지 점검해야 해요. 출처가 공공기관 보고서나 논문, 책, 신문 기사라면 신뢰할 수 있지만, 개인이 운영하는 소셜 미디어 계정, 블로그라면 내용을 그대로 믿으면 안 돼요.

마지막으로, 정보를 비판적으로 읽는 힘을 길러야 합니다. 생성형 AI는 확률적으로 단어를 조합하는 방식이므로, 언제든 틀릴 수 있다는 점을 마음에 새겨야 해요. 모르는 것이 생길 때 생성형 AI에만 의지하지 말고, 먼저 스스로 찾아보는 습관을 들여 보세요. 궁금한 내용이 담겨 있는 책과 자료를 찾아보는 과정에서 좋은 정보를 선별하고 판단하는 능력을 기를 수 있어요. 요즘 우리 일상에는 생성형 AI가 만든 잘못된 정보가 곳곳에 섞여 있어요. 정보의 출처를 꼼꼼히 확인하고 비판적인 눈을 가져 할루시네이션에 속지 않도록 노력해 봐요!

Level Up! 디지털 바른 생활 영상 읽어줌