지난 호까지 우리는 로보트 재권V의 팔, 다리, 몸통, 머리, 전원공급, 인공지능을 만들어 봤습니다. 상당히 진도가 많이 나갔습니다. 그러나 로봇을 완성하기까지는 아직 가야할 길이 멉니다. 이번 호에서는 로보트 재권V가 우리와 함께 지내기 위해서 꼭 필요한 기능 중 하나인 주변 상황을 파악하는 방법에 대해 다뤄 보겠습니다.

우리는 지금까지 로보트 재권V에게 어떤 기능을 만들어주려고 할 때 항상 인간에 대해서 먼저 살펴봤습니다. 이번에도 우리 인간이 어떻게 주변의 상황을 파악하는지부터 알아보겠습니다.

인간은 멀리 떨어진 곳에서 벌어지는 상황을 파악하기 위해서 눈에 들어오는 빛 정보를 가장 많이 사용합니다. 지난 호에서 사물 인식과 딥러닝(Deep learning)을 다룰 때 로봇의 비전 인식 방법을 알아본 것도 이런 이유 때문입니다.

그런데 빛이 없는 곳에서는 어떻게 해야 할까요? 인간은 빛 외에도 공기의 움직임인 파동을 파악하거나 공기 중에 섞여있는 화학물질을 포착합니다. 공기의 움직임은 귀를 통해 인지되는 소리, 화학물질은 코를 통해 느끼는 냄새이지요. 그래서 청각과 후각이 발달한 사람은 먼 곳에서 무슨 일이 벌어지는지 잘 알아내곤 합니다.

생존을 위한 청각과 후각

사실 인간의 뇌는 시각을 통해 들어온 빛 정보를 처리하기 위해 매 순간 상당히 많은 일을 하고 있습니다. 그래서 청각, 후각, 미각, 촉각 등 다른 감각에 집중하기 위해서는 눈으로 들어오는 정보를 차단해야할 정도입니다.

좋아하는 노래가 흘러나와서 음악에 집중하고 싶을 때, 맛있는 요리가 나와서 온전히 음식의 맛만 음미하고 싶은 때, 좋은 향수를 고르기 위해서 향기를 맡아볼 때, 연인과 포옹을 하며 서로의 따뜻함을 느끼고 싶을 때, 인간은 자연스럽게 눈을 감곤 합니다. 시각 정보를 차단하면 청각, 후각, 미각, 촉각 등 다른 기관의 정보에 집중하게 되죠.

영화를 만드는 분들은 이런 현상을 참으로 잘 이용하는 것 같습니다. 공포 영화에서 관객들을 놀라게 하기 위해 먼저 영화 장면을 어둡게 만듭니다. 화면이 잘 안보이게 만드는 것이죠. 그러면 관객들은 시각 정보가 차단되기 때문에 영화를 보기 위해서 청각에 온 신경을 집중합니다. 이렇게 청각이 극도로 민감해진 상황에서 갑자기 큰 소리가 나면 관객들은 평소보다 더 깜짝 놀라게 됩니다. 인간의 감각에 대해 잘 이해하고 있기 때문에 사용할 수 있는 기술인 셈입니다.

후각은 생존을 위해서 꼭 필요한 기능입니다. 인체에 유해한 화학물질은 인간의 목숨을 위협할 수도 있는 만큼 멀리해야합니다. 그래서 우리는 그런 화학물질에 가까이 가면 코를 막고 악취가 난다고 하면서 멀어지려고 합니다.

진화생물학적으로는 냄새를 통해 주변의 화학물질도 잘 파악하고 멀리서 일어난 일도 소리를 통해 잘 들을 수 있는 인간이 살아남을 확률도 높다고 해석할 수 있겠습니다.

그렇다면 로보트 재권V를 만들 때도 소리를 잘 듣고 냄새를 잘 맡게 해야 인간에게 도움이 되는 로봇이 되지 않을까요? 그래야 우리가 “로보트 재권V야, 이게 무슨 냄새니?”라고 묻거나 “로보트 재권V야, 무슨 소리 안 들려?”라고 말했을 때 우리가 알고 싶어 하는 정보를 로보트 재권V가 바로바로 알려줄 수 있을테니까요.

AI 스피커처럼 음성 인식

소리를 듣는 것은 로봇이 인간과 같이 살아가기 위해서 꼭 필요한 기능입니다. 왜냐하면 인간은 대부분 말을 사용해서 로봇과 의사소통을 할 테니까요. 로봇이 인간의 소리를 듣지 못하면 인간과 의사소통하기가 힘들 겁니다.

로봇이 소리를 잘 듣기 위해서, 그리고 그 소리가 어떤 소리인지 잘 파악하기 위해서는 어떻게 해야 할까요? 가장 먼저 생각나는 것이 마이크입니다. 인간은 오래전부터 말하는 것을 듣고 기록하기 위해 라디오, TV 등 수많은 음향기기를 만들었습니다. 아주 훌륭한 기계들입니다.

마이크는 공기의 떨림을 전기신호로 바꾸는 기계입니다. 그 전기신호를 스피커에 연결하면 스피커에서는 전기신호가 소리로 바뀌고 우리 귀가 들을 수 있게 됩니다. 소리를 모아 이를 멀리 떨어진 곳으로 전송하는 기술은 이미 100여 년 전에 만들어졌습니다.

그런데 문제는, 그 소리가 어떤 소리인지 로봇이 스스로 알아내야 한다는 것입니다. 전기신호로 전환된 소리는 그저 전기신호일 뿐 아무런 의미가 없습니다. 마이크를 통해 만들어진 수많은 전기신호 중에 인간이 한 말이 어떤 것인지 구분할 수 있어야 하고, 더 나아가 인간의 말이 어떤 뜻인지도 스스로 알아내야 합니다.

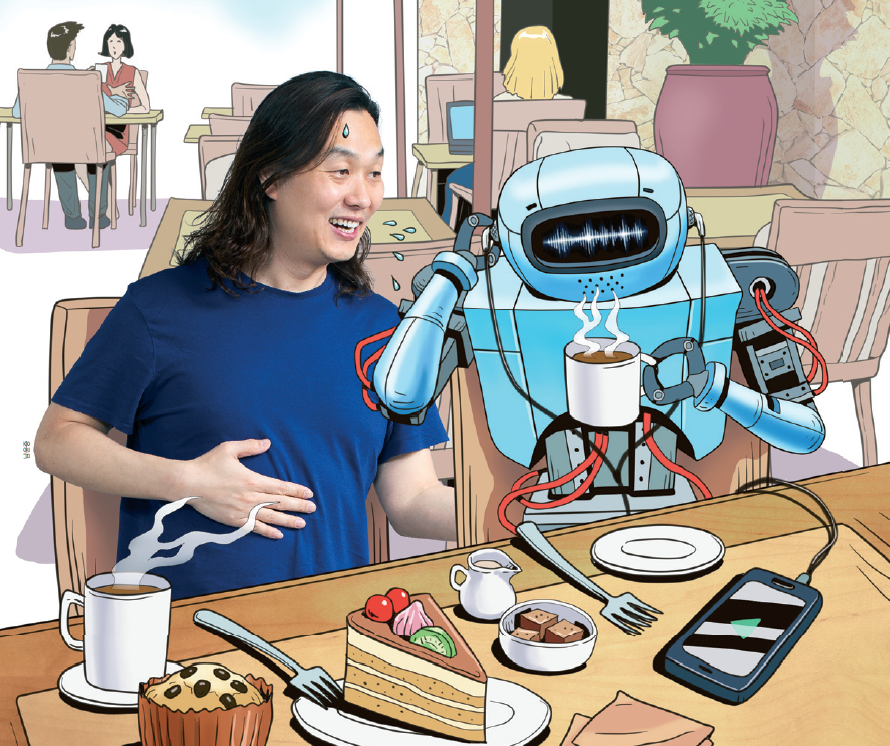

“로보트 재권V야, 물 좀 가져다줘!”라고 명령을 내린다고 합시다. 로봇은 ‘로보트 재권V’라는 자기 이름을 인지할 수 있어야 하고, ‘물’ ‘가져다줘’ 같은 소리가 어떤 뜻인지도 파악할 수 있어야 합니다. 그리고 냉장고 안에 있는 물을 찾아서 들고 옮기는 일까지 수행할 수 있어야 합니다. 그래야 명령에 대한 실행이 완료됩니다.

이 모든 과정은 쉬운 일이 아닙니다. 인간이 쉽게 할 수 있다고 해서 로봇도 쉽게 할 수 있을 것이라는 생각은 큰 오산입니다. 인간이 쉽게 하는 일은 로봇에게는 어려운 일인 경우가 많습니다.

마이크를 통해 전기신호로 변환된 데이터가 무엇을 의미하는지 어떻게 알아낼 수 있을까요? 최근 인공지능 스피커들이 많이 보급되면서 재미있는 장면을 종종 보게 됩니다. 인공지능 스피커에 “뉴스 좀 틀어줘”라거나 “노래 좀 틀어줘”라고 하면 그 말을 알아듣고 뉴스도 틀어 주고 노래도 찾아서 들려줍니다. 정말 신기합니다. 우리도 로보트 재권V에 이 기능을 넣으면 되지 않을까요.

이런 기능을 음성 인식이라고 부릅니다. 사람이 하는 말의 의미를 파악하는 기술입니다. 음성 인식 기술을 만들어 내기 위해서 정말 많은 엔지니어들이 오랫동안 연구를 해왔습니다. 현재 사용되는 방식은 지난 호에 소개했던 컴퓨터 신경망 프로그램입니다. 지난 호에는 사진을 학습했다면 이번에는 소리를 학습하는 것입니다.

많은 사람들이 ‘물’이라는 단어를 말한다고 가정해 봅시다. ‘물’이라는 말을 전기신호로 바꾸면 사람마다 모두 다른 전기신호가 만들어 집니다. 전기신호만 놓고 보면 도저히 같은 단어인 ‘물’을 말했다고 생각할 수 없을 정도입니다. 이를 논리적으로 프로그래밍하기는 불가능해 보입니다.

그래서 컴퓨터 신경망 프로그램은 ‘물’이라는 수많은 음성 데이터를 입력한 뒤 이 모든 데이터가 ‘물’이라는 말을 뜻하는 것이라고 학습합니다. 학습량이 많아지면 많아질수록 컴퓨터 프로그램은 발음, 길이, 억양에 관계없이 ‘물’을 ‘물’로 추정할 수 있게 됩니다.

다시 말해 인공지능 스피커는 수많은 사람들이 각기 다른 음성으로 표현한 단어들을 데이터로 학습한 결과물입니다. 비록 아직까지 완벽하게 알아듣는 수준은 아니지만, 시간이 지날수록 더욱 말귀를 잘 알아듣게 될 겁니다.

화학 반응으로 냄새 알아내는 전자 코

이번에는 후각으로 넘어가 보겠습니다. 로봇이 냄새를 맡을 수 있을까요? 사실 인간의 코는 정말 잘 만들어진 센서여서 인간만큼 뛰어난 코를 만들기는 쉽지 않습니다. 그러나 과학자들은 오래 전부터 전자 코(Electronic nose)를 만들기 위한 연구를 진행하고 있습니다.

전자 코는 화학 반응을 이용해서 공기 중의 화학물질을 파악하는 기계라고 생각하면 됩니다. 소형 선풍기 같은 팬을 통해 공기를 흡입한 뒤 공기 중에 섞인 화학 성분을 분석해 내는 것이죠. 화학 반응이란 A라는 화학물질이 B라는 화학물질을 만나 C라는 새로운 화학물질을 생성하는 경우를 말합니다.

가령 우리가 B라는 화학물질을 상자에 넣었다고 가정해 봅시다. 그런데 어느 날 갑자기 B가 C로 변했다면 공기 중에 A가 있었음을 추정할 수 있습니다. 거기에 C가 얼마나 많이 만들어졌는지 양까지 파악할 수 있다면 공기 중에 A가 얼마나 많이 있었는지도 추론할 수 있습니다. 그래서 C가 만들어진 만큼 전기신호가 발생하도록 만들면 전자 코가 완성되는 셈입니다.

여기에 C뿐만 아니라 다른 화학물질에 반응하는 D, E, F 등 다른 물질들도 전기신호를 발생시키게 만들면 정말 훌륭한 전자 코가 되겠죠. 요즘 바이오나노 분야가 발전하면서 탄소나노튜브, 그래핀 등을 이용해 화학 반응을 전기신호로 바꾸는 다양한 방법들이 개발되고 있습니다.

이제 로보트 재권V는 소리도 듣고 냄새도 맡으며 더욱 똑똑한 로봇으로 변신하고 있습니다. 조금만 더 개발하면 우리 곁에서 우리와 함께 지낼 수 있는 로봇이 될 것 같습니다. 다음 호에서는 감정을 표현할 수 있는 표정에 대해 알아보도록 하겠습니다. To be Continued.

한재권

한양대 로봇공학과 교수다. 휴머노이드 로봇 개발을 비롯해서 인간과 로봇간의 상호작용 연구를 활발하게 수행하고 있다.

jkhan@hanyang.ac.kr