지금까지 개발된 컴퓨터와 인간의 대화 방법은 키보드와 마우스가 고작이다. 그러나 만약 눈빛만으로 커서를 움직이고, 사람의 표정을 살펴 명령을 수행하는 컴퓨터가 등장한다면 '컴맹'이란 단어는 사라질 것이다.

현재 컴퓨터에게 우리가 원하는 일을 시키는 방법은 키보드나 마우스로 명령을 내리는 것이 대부분이다. 좀 더 쉽고 편하게 대화하는 방법은 없을까. 컴퓨터 인터페이스의 발전된 형태로는 사람의 목소리를 알아듣는 컴퓨터나, 문자를 인식할 줄 아는 컴퓨터가 있다. 그러나 문자인식, 음성인식 컴퓨터가 상용화되려면 시간이 걸릴 듯 싶다.

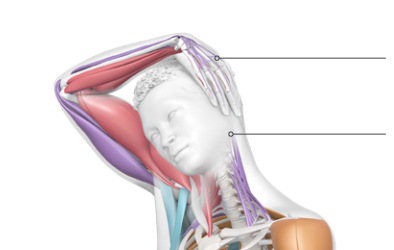

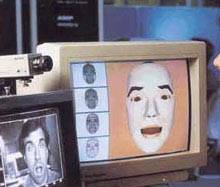

이외에도 컴퓨터와 원활한 대화를 위한 기술 개발은 여러 방면으로 진행되고 있다. 사용자의 제스처나 얼굴의 움직임, 표정 변화를 알아차리는 컴퓨터가 바로 그것이다. 컴퓨터에 카메라를 부착시켜 카메라를 통해 입력되는 사용자의 얼굴 영상으로부터 사용자의 얼굴 움직임을 파악하는 것이다. 즉 컴퓨터가 ‘주인의 눈치’를 볼 수 있게 만들어주는 것이다.

사람의 표정을 읽는 컴퓨터가 할 수 있는 일은 무궁무진하다. 일단 손으로 일일이 마우스를 움직이지 않아도 된다. 컴퓨터 앞에 앉아 스크린 상에 있는 커서를 응시한 뒤 어디로 움직일지를 눈으로 가리키면 되는 것이다.

또 스크린에 손을 대서 조작하는(터치 스크린) 현금 자동 입출금기, 자동 티켓 발급기 등의 무인 안내 시스템도 얼굴 표정으로 조작할 수 있다. 자동 안전 장치도 마련할 수 있는데, 운전자의 얼굴이나 눈 상태를 계속 감시하다가 운전자가 조는 경우 경보음을 내거나 주행속도를 감속시키는 장치로 응용할 수 있다.

사람의 눈빛이나 표정을 읽을 수 있는 컴퓨터가 할 수 있는 일 중 가장 대견스러운 것은 장애자들을 돕는 일이다. 선천적으로 혹은 후천적으로, 얼굴을 제외한 다른 신체 기관의 움직임이 어려운 장애인들이 얼굴의 움직임만으로 컴퓨터나 기타 외부 장치들과 명령을 주고 받게 된다는 것은 상상만 해도 흐뭇한 일이 아닐 수 없다. 장애인이라고 해서 문명의 이기를 누릴 기회가 없다는 것은 억울한 일이 아니겠는가.

주인 눈치 보는 컴퓨터

얼굴의 움직임을 이용해 마우스를 제어하거나 혹은 사용자의 응시 위치를 파악하기 위해서는 여러 가지 연구가 필요하다. 먼저 카메라를 통해 입력된 영상으로부터 얼굴 내의 특징점들을 빠른 시간 내에 추출해야 된다. 이를 위해서는 실시간 동영상 처리 기술이 필요하다. 또 추출된 특징점들로부터 사용자의 얼굴 움직임과 응시 위치를 파악할 수 있는 3차원 컴퓨터 비전 기술도 요구된다.

이렇게 얼굴의 움직임을 파악하고자 하는 연구는 국내보다 국외에서 활발히 연구되고 있다. 대부분이 얼굴에 특수한 장치를 하고 이것을 별도의 센싱장비로 추적하는 방법이다. 즉 적외선이나 전자기장으로 얼굴에 있는 ‘마킹점’을 추적해 그 움직임을 파악하는 것이다. 현재 상용화된 것은 적외선 센싱을 이용한 오리진사의 ‘헤드 마우스’ 프렌트케 로미히사의 ‘헤드 매스터’ 그리고 전자기장 센서를 이용한 폴해머스사의 ‘3 스페이스 패스트랙’이 있다. 그러나 최근에는 이런 특수장비 없이 카메라를 통해 사용자의 얼굴 움직임이나 모니터의 응시 위치를 실시간으로 알아내려는 연구가 미국의 MIT, 일본의 오사카 대학, 그리고 연세대 전자공학과 등에서 활발히 진행 중이다.

카메라로 사람의 표정을 읽는 방법도 있다. 이는 적외선 같은 특수 장비를 이용하는 것보다 해상도는 떨어지지만 설치비용이 저렴하다. 그래서 무인 감시 시스템이나 가상현실 게임 등 특별히 높은 정확도를 요구하지 않는 분야에서는 활용도가 높을 것으로 기대된다.

사람의 표정이나 눈빛, 제스처, 더 나아가 음성까지 알아들을 수 있는 컴퓨터는 더 이상 기계가 아닐지 모른다. 인간을 위해 만든 기계를 더 인간답게 꾸미는 일은 인간과 기계 사이의 보다 발전된 휴먼 인터페이스 환경을 꾸미는데 결정적인 노릇을 할 것이다.