울고 웃고 슬픔에 잠긴 로봇이 등장할 것 같다. 일본 도쿄대학 공학부 하라 후미오교수는 최근 개최된 얼굴 심포지엄에서 인간처럼 희노애락을 얼굴 표정에서 구현하는 로봇연구 결과를 발표했다.

앞으로 로봇이 인간과 적극적으로 커뮤니케이션하기 위해서는 로봇의 감정(?)을 표현할 수 있어야 한다. 로봇의 얼굴에 세세한 움직임을 구현하기 위해서는 조그만 움직임에도 원활하게 움직이는 FMA(Flexible Micro Architecture)가 배치되고 그 위에 실리콘고무가 둘러싸여져야 한다. FMA의 강성 및 가공조건 때문에 표정을 가진 로봇얼굴의 크기는 실제 성인 얼굴의 1.2배 정도.

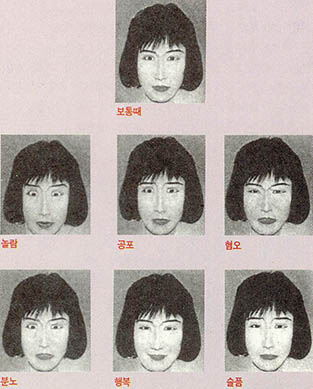

이 로봇은 놀라고, 공포에 떨고, 혐오스러워하고, 분노하고, 행복해하고, 슬픔에 잠기는 인간얼굴의 6가지 기본표정을 눈썹 입술 코 등 18개의 제어지점의 운동을 조합시켜 표현했다. 이를 30명의 사람들에게 보여준 결과 83.3%라는 인식률을 나타냈다. 이 로봇은 눈에 CCD카메라가 부착돼 있어 상대방의 표정을 읽어들이는 것이 가능하다. 인간의 표정변화를 추적해 따라하는 실험에서는 사람얼굴 표정이 변하는 시간보다 약 4배의 시간이 걸렸다. 시간 단축이 앞으로의 과제.